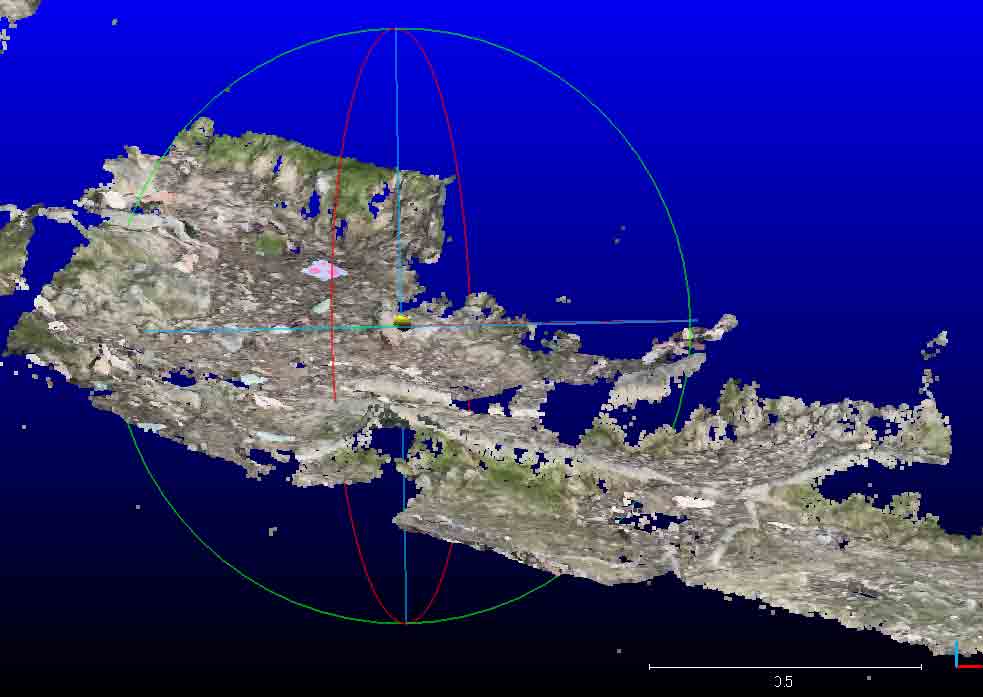

裸岩露頭のiPhone 12 Proを使った点群撮影 acquisition of point cloud of rock outcrops by iPhone 12 Pro

はじめに

iPhone 12 Proを使って3Dスキャンするさし当たりの目標は,海岸地形の測量ツールとして使えるかである。屋外の岩柱や室内のソファについては,EveryPointと比べると,Scaniverseの絵作りが良かった。岩柱については iPhone 12 Proで3Dスキャン 3D LiDAR scanning with iPhone に示している。で,昨日Feb. 15, 2022,亀岡市のタニハのそばの墓地造成地で切り通しのスキャンをした。その結果にガッカリした。自宅周辺でどこか適当な撮影場所は無いかと考えて,小規模ではあるが思い立って,徒歩15分ぐらいだろうか白姫神社後背の箕面山地中の勝尾寺参道に午後5時前に行き,ここで取り上げている二種のアプリを試した。そして同様の結果を得たのである。まずはその結果を簡単に示し,これまでと変わらず試行錯誤して行きたいと思う。

1 スキャニバースは広い場所は苦手:白姫神社 練習1 Feb. 16, 2022

昨日の亀岡の墓地造成地での結果はこの白姫神社後背の試行と同じなので,省略する。同様の問題点が再現したという意味で徒労ではなかった。

図1のランドマーク(径58mm)を作成した。一つの比較的長い露頭を二回に分けて撮影し,その二つの点群をCloudCompare上でマージするという実験をするべく,その重なるエリアに4カ所のランドマークを設置したのである。ランドマークの白域2カ所に地点番号を書いて,ツマヨウジ2本で土に固定する。

まあ3Dスキャンを例えば100m長の場で実行したくてもソフトウェアの点でうまく行かないかも知れない。それでスキャンを複数回に分けて実行し,CloudCompareでその複数のファイルを指定assignして一つにまとめるといった発想である。実験は極めてコンパクトな範囲で実施したが,これでさえもうまく出来なかった。測定場所の動画を次に示している。酔いそう。

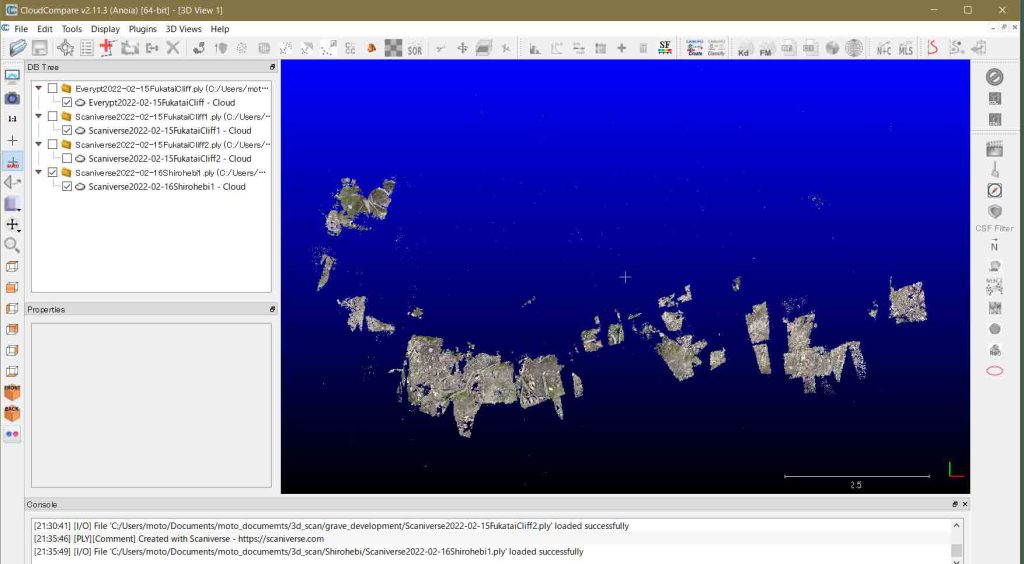

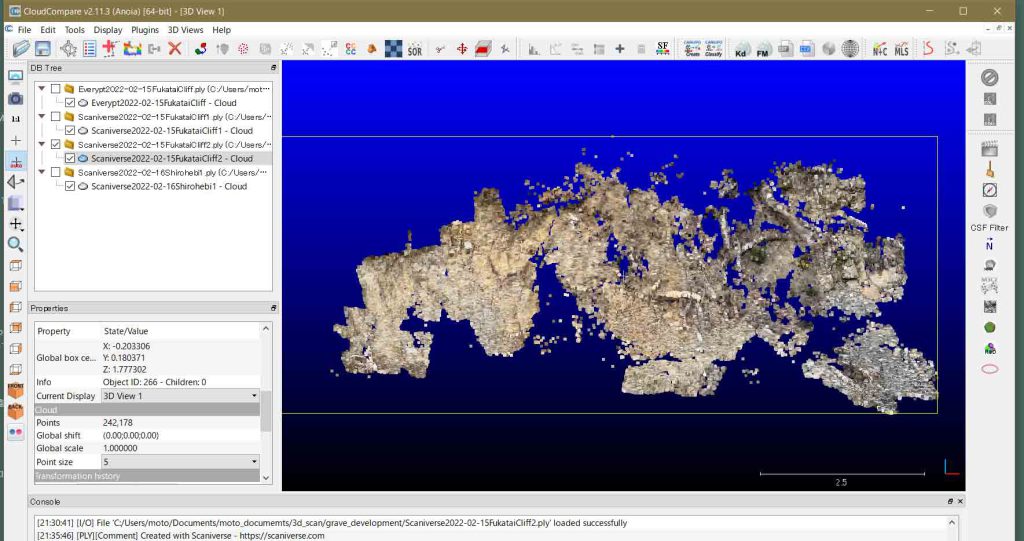

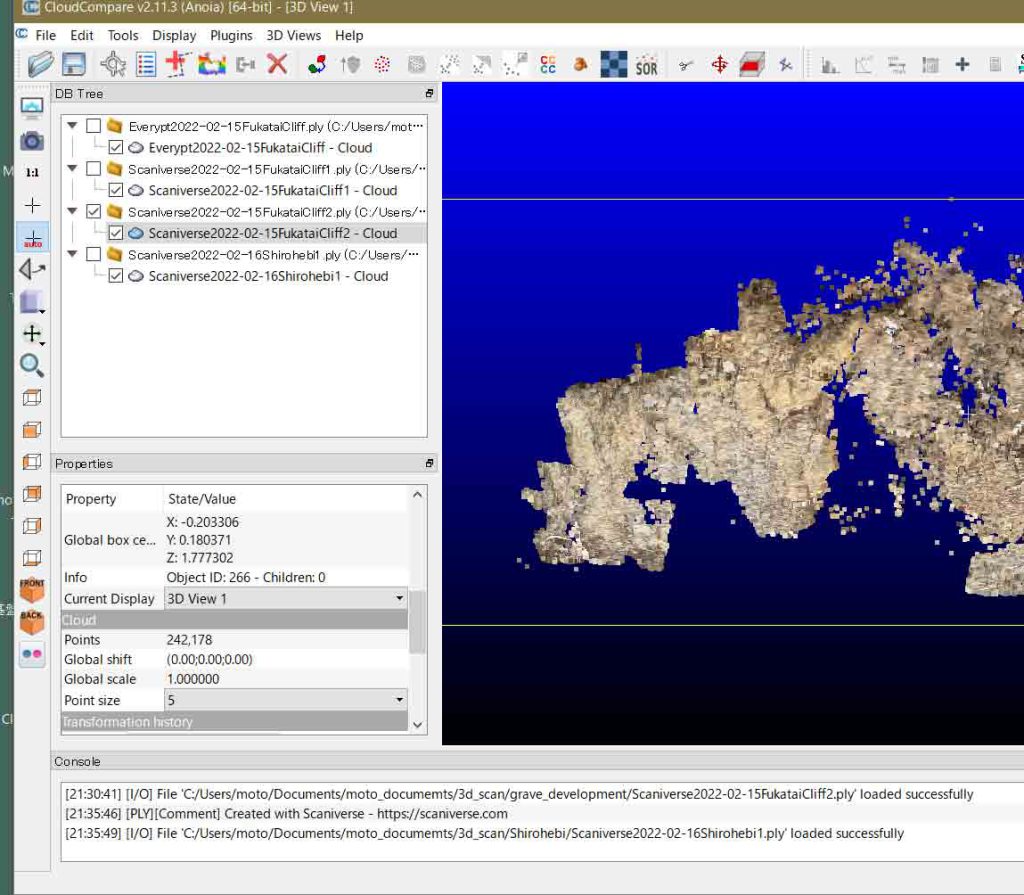

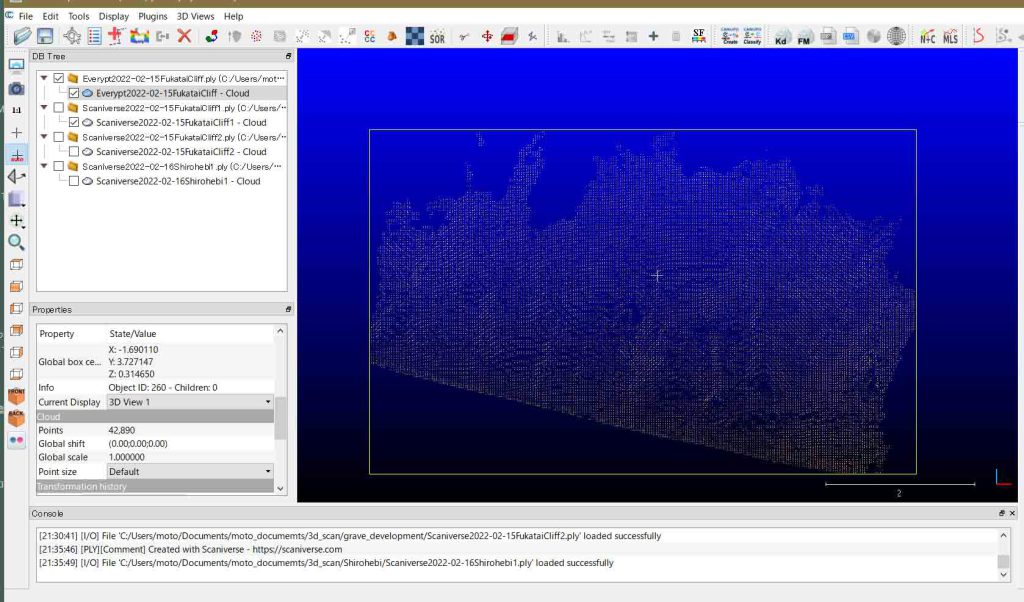

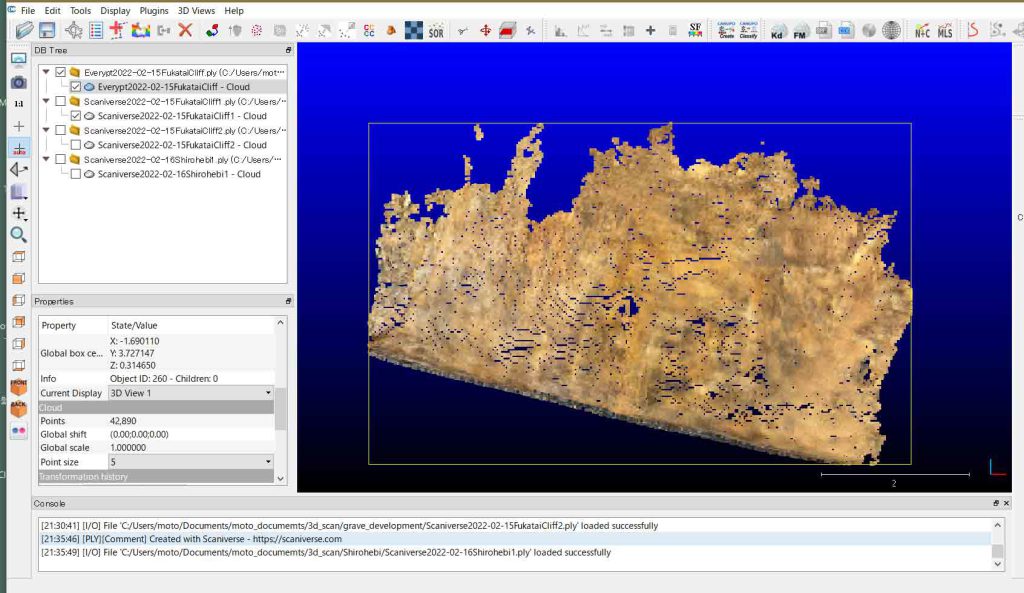

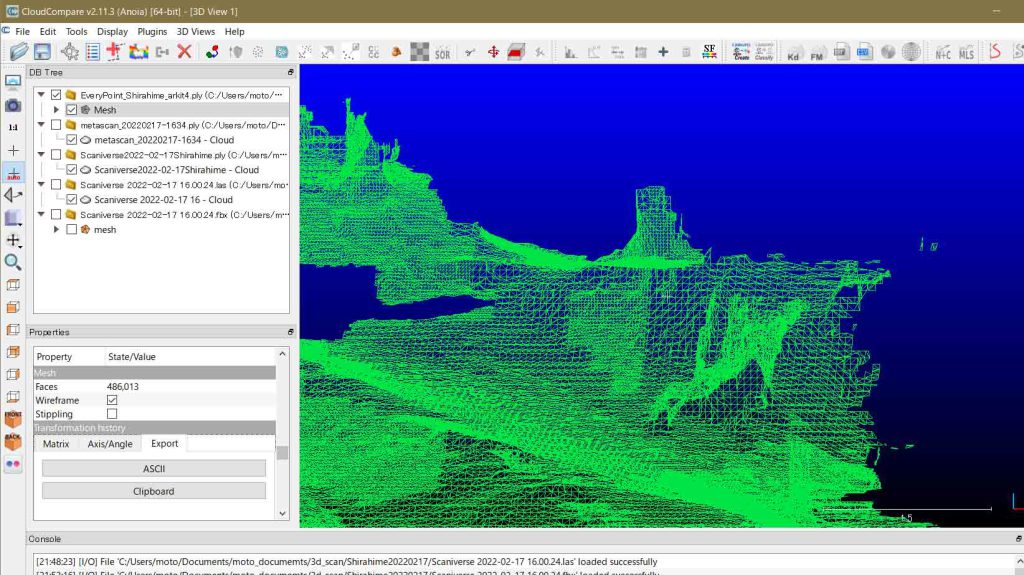

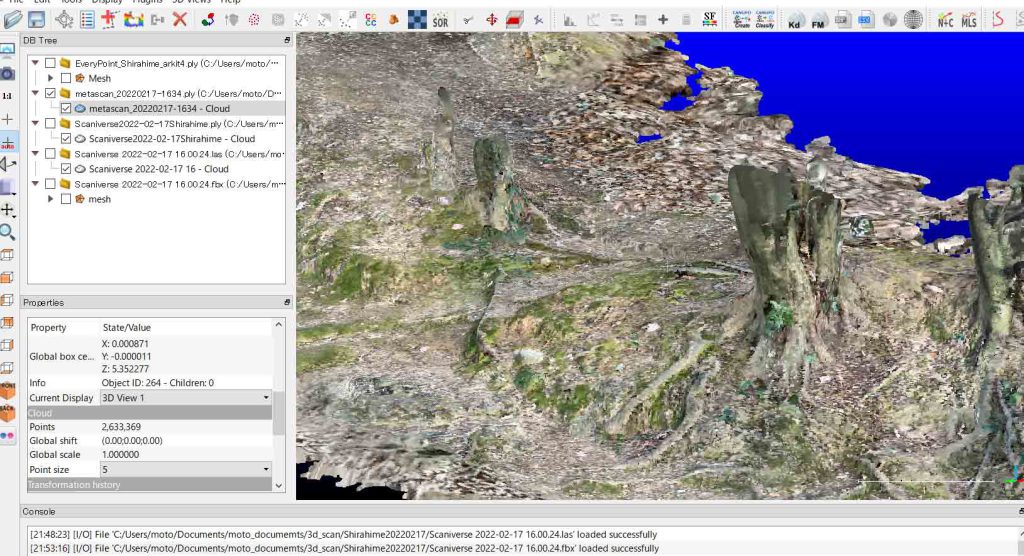

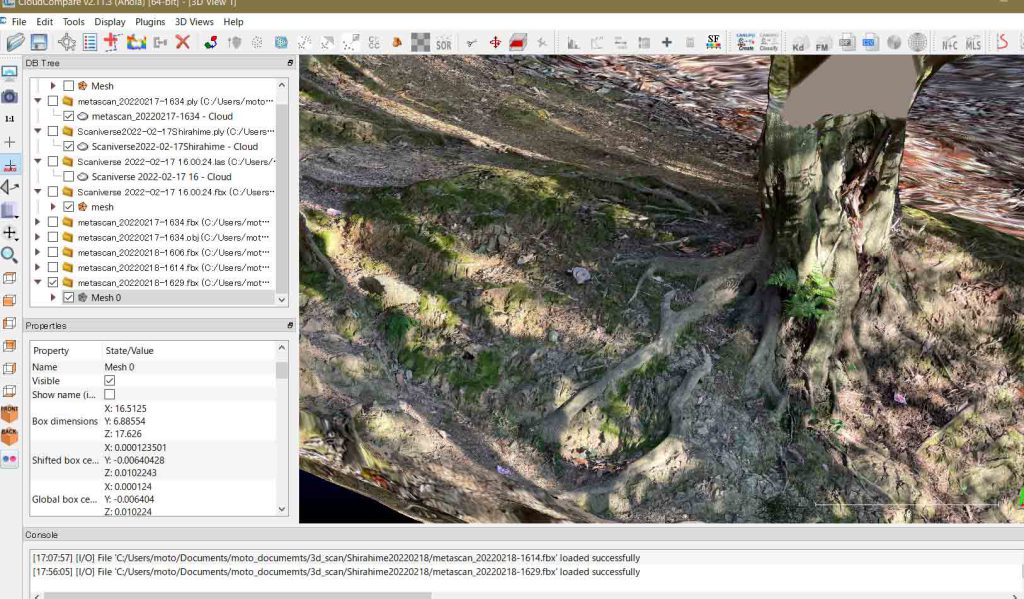

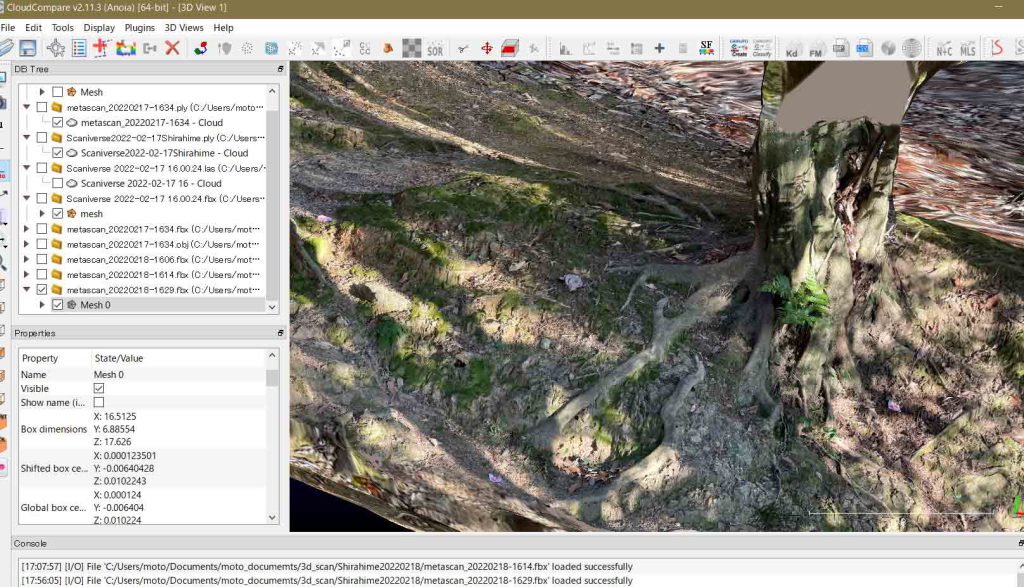

まずは,Scaniverseで2分割撮影した。次の図2と図3は出力された.plyファイルである。撮影範囲は,図2で10m,図3で距離8mほどである。何れの撮影も連続的に実施したが,Scaniverseが勝手に削除しまった。撮影してすぐの画面を見ると切れ目が無いのであるが,saveを実行すると脱落する。保存様式に軽いものから重いものまで三段階あり,図2は,重いファイル(精細ファイル)として保存した。画面で見ていると保存に時間がかかり,iPhone 12 Proをポケットに入れて時々,進行具合を見るというような形を取った。図2のような断裂に遭遇したので,次に撮影する際には,精細度を中間にした。デフォルトの選択である。その結果が図3であった。図3左下のPropertiesの最下段にはPoint size 5としているのでポイントのサイズが大きくなったので,画面の密度が高くなったように見え,見かけ上,図2よりも情報密度が多いように見えるだけである。

save時に,精細度を下げると脱落度は減少するのであるが,次のように,精細度大の場合には見えたものが,精細度を中つまりデフォルトにすると見えなくなる現象を次の例から示したいと思う。

図4(図2と違い図3同様,ポイントサイズを5に拡大している)中の画面のほぼ中央に白っぽい□が見える。これは図5の陸標である。この陸標は図3ではCloudCompareのディスプレイで種々探しても,みつけることが出来なかった。デフォルトの解像度では距離1〜2mでスキャンした地上の陸標すら読み取ることができないのである。これでは3Dスキャン点群と,光波測距儀などによる測量との対応関係を付けることができず,使い物にならないのである。

結局,Scaniverseはぼくの利用目的に対応していないことがわかる。エブリポイントとは違って,地表をゆっくりスキャンして行くと,スキャンが終わったところは,iPhone 12 Proの画面で見ても映像がはっきりしていて,スキャンが終わった場所がはっきりと反映されている。赤白斜めパターンが生じないのである。操作性は凄くいいと思う。撮影して感じることは,Scaniverseの画面では,iPhone 12 Proの上縁付近から地上を検知し,少し光軸はレンズの鉛直方向よりも手前にあるようで,撮影対象物に対して上から掬い取るようなイメージである。カメラの光軸を水平より上向きにすると検知しない傾向がある。検知範囲は一応5m(3cm精度)として使っているが,2mぐらいまでしか検知しないように思うのである。とはいえ,このように注意しても生まれる点群は極めて不完全なもので,ぼくには使い物にならない!! 無料故に制限がかかっているのではと調べたがそういう情報も無いのである。

以上,Feb. 16, 2020記。

さて,スキャニバースを完全に捨て去るのは,狭い範囲ではあっても,表現力は捨てがたいものがある。図6は水平軸からの像である。この付近は結構丁寧に地上高1m余りから歩き回って撮影したものである。右下のスケールは0.5m,ポイントサイズ4での表示である。歩いた感触とこの画像を見ると,ほぼ合致している。cloud pointの欠落の理由は,スキャンの当時の丁寧さなどからは思いあたらない。

スキャニバースが使える場所は,最大2m四方ぐらい。光波測量との関係を求めるには,1カ所(または2カ所)に地表を置けば良い。もう複数の3Dスキャン点群のマージはあり得ないのである。

2 エブリポイントは地表の肌理表現力ゼロ:白姫神社 練習2 Feb. 16, 2022

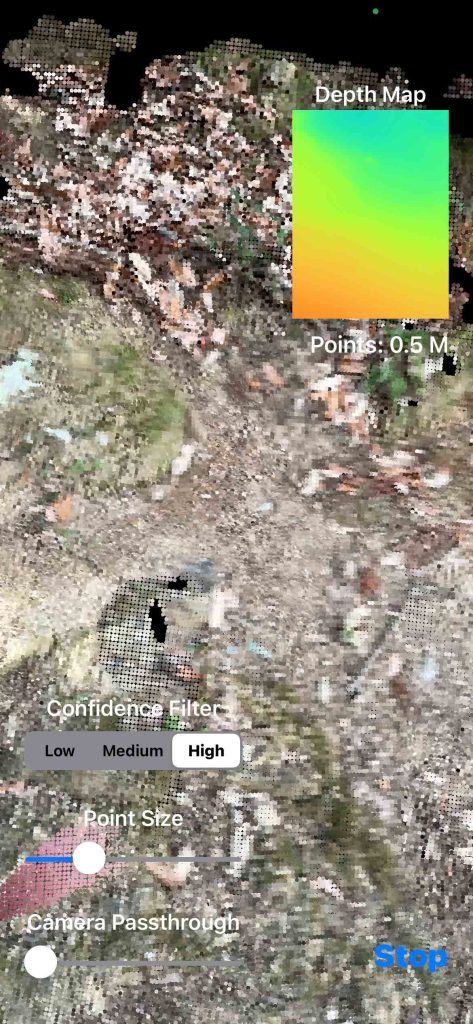

さて,エブリポイントを捨てきれず,ここでもあまり期待せずに狭い範囲を実施した。もう暗かったのでいい実験ではなかった。森林のなかで日が落ちていたからである。図7のpoint sizeはデフォルト,図8は5である。この図8では,陸標ラベルを見つけることができなかった。

取得された点群では陸標のラベルを見つけることができず,使用に耐え得ないものであった。ただ,次の一手があって,本日試みる予定である。スキャニバースでは,図6のように,木の根の張りなどを画像から簡単に読み取ることができるが,エブリポイントは図8のように,木の根も岩石の一部のように見えている。画像としては全く使えない。

一応,エブリポイントの現場での使用感を次に示す。視野はスキャニバースに比べるとかなり広い。撮影対象はまずは赤〇が点点と現れる。比較的遠く(10mほどか)の木々にも赤〇が付く。黄〇から緑〇に変わって行くのは近い部分である。カメラ視野はiPhone 12 Pro上縁よりもスキャニバースと比べると広い範囲がスキャンできている。視野の水平軸よりも上方にまで拡がっており,ぼくの身長よりもかなり高い(3m?)ところまでスキャンできている。この点がエブリポイントの魅力ではある。繰り返すが,画像としては全く使えない。

3 スキャニバースの使い方は,エブリポイントはARKit,そしてメタスキャンの機能チェック:白姫神社練習 Feb. 17, 2022

本日Feb. 17,遅い昼食の後,また白姫神社に出向く。その実験予定を次に。

1 スキャニバースで,ほぼ2m四方について,詳細なスキャンを実行してみる。当然,精細モードでの保存を実行する。

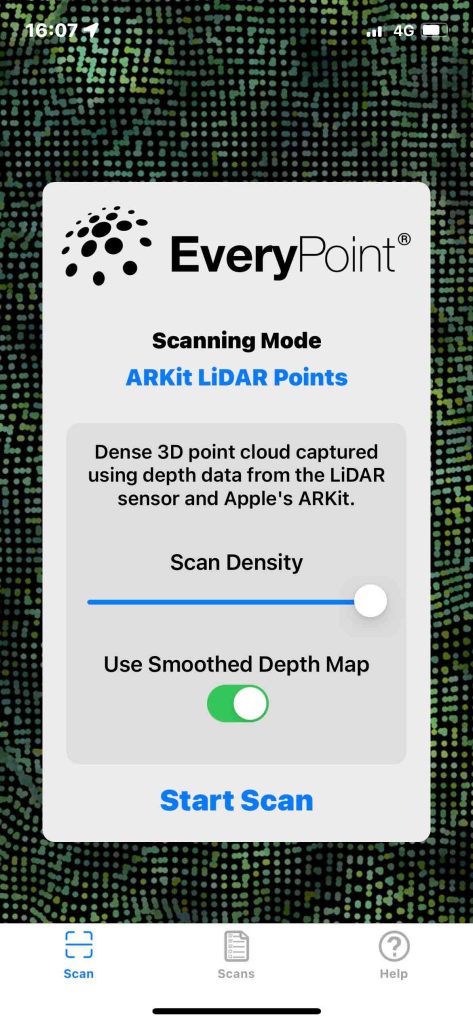

2 エブリポイントについては,「EveryPoint LiDAR Fusion」は,使えないことがわかった。次のページに岩間さんの3Dスキャナ比較表があって,このEveryPointの良い点として示されていることに感謝。それは,「撮影範囲が無制限のARKitモード,撮影範囲に制限はあるが,ノイズの少ないEveryPoint LiDARモード」という情報。室内のソファを撮影した際に,ノイジーな絵作りに驚いて,捨て去ったARKitモードが屋外の広い範囲の撮影に有効かも知れないということである。

3D Scan 【iPhone12 Pro / iPadPro 2020】Metascan(旧Forge)を使用して3Dモデル空間を作成する

エブリポイントのARKitモードを検証する。室内での作業結果は次のページに示している。

iPhone 12 Proで3Dスキャン 3D LiDAR scanning with iPhone

Scan 3: ARKit Lidar Points,Scan Densityを設定,Smoothing Depth Map設定オン,confidence filterをhighとして撮影。

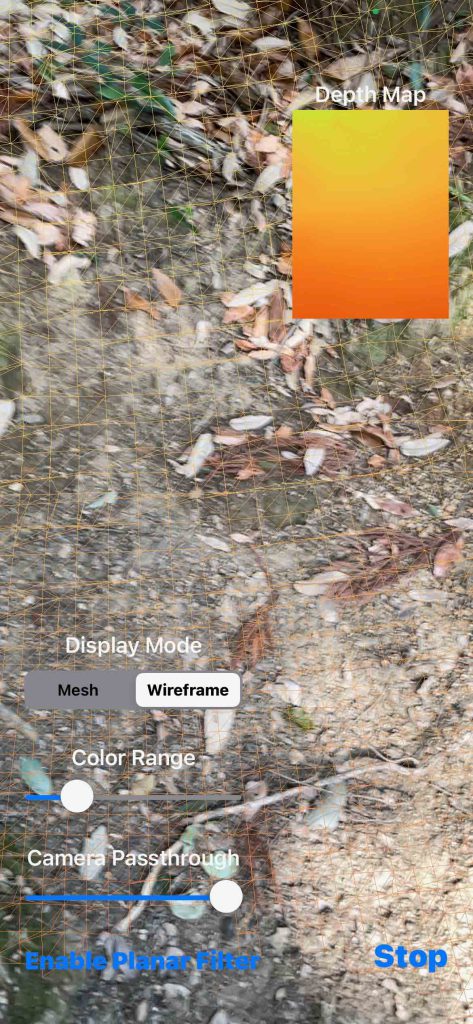

Scan 4:ARKit Lidar Mesh,撮影時wireframeを選択。

3 メタスキャンの導入

これについては前掲のページ 3D Scan 【iPhone12 Pro / iPadPro 2020】Metascan(旧Forge)を使用して3Dモデル空間を作成する を参考にする。課金は5500円/年,780円/月,となっている。さし当たり昨晩Feb. 17,一週間の試用を選択した。アップルストアから連絡があり,ほっていたらそのまま登録状態になるようなので,Feb. 22に決断する必要がある。課金されないレベルの使用環境ではぼくには役に立たないのは確実であるが,課金されて使い物にならないのではどうしようも無い。調査に行って,当日1ヶ月分の契約をすればいいので,決して高くはない。

「Metascanは空間生成に特化しており、スキャンをすることによって生じる現実との誤差が極めて少ないとSNSでも話題になっています

Color: 被写体をモノクロにし、スキャンができている被写体の範囲が彩色されていったり、逆にスキャンされた箇所を無彩色のポリゴンで表示させる機能

Camera: 被写体にズームする機能

Follow: ヴァーチャル空間上にスキャンされた被写体を表示していく機能

Above: 地面をフォーカスし、撮影者の動きをトラッキングして撮影しやすくなる機能」

Metascan – 3D Capture このアップルストアのレビューを次に。

enthuce

2021/07/04

広域のスキャンが得意

LiDAR カメラで物体をスキャンして3Dモデルを作るAppは数ありますが、ForgeはUIが洗練されていることが特徴です。特にミニマップに上面図を表示しながらスキャンできるモードは素晴らしく、広域でも穴のないスキャンを行うことができます。

動作も今はかなり安定しており、数十メートル四方は問題なくスキャンできます(メモリが一杯に近づくと教えてくれます)。また色合いを自動調整してくれているようで、他のAppより均質で見栄えの良いテクスチャを作ってくれます。

という訳で,使ってみよう。写真測量機能もあるので,これも。

以上,before lunch, Feb. 17, 2022記。

4 スキャニバースは狭い範囲を詳細に:白姫大明神,Feb. 17, 2022

白姫神社ではなくて,白姫大明神だった。見えていなかった。祠がない。井戸と手水石のような。住所と名前が刻まれた石柱が並んで柵があるが,これを玉垣というらしい。豊中や箕面大字名とともに小豆島もある。さて,ラベルを4枚設置した。前日とはLoc. 4以外は違う場所である。ラベルは単に3Dスキャン図に見えるかどうかの確認のためだけである,今日は。

まずは,スキャニバースの確認である。広い範囲のスキャンは諦めたが絵作りがいいので捨てがたい。まあ言わば舐めるようにスキャンした。一渡りスキャンした後,出発点まで戻って確認した。

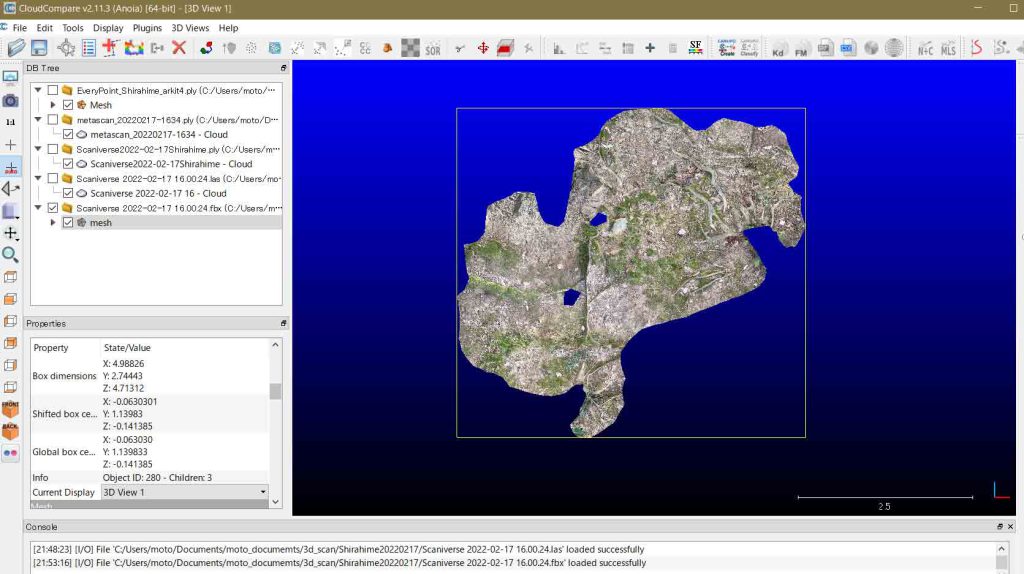

図11は外部出力前の表示である。ところが,PLY出力したものは,孔も大きく,周辺もギザギザになっている。PLY出力をすると,スキャニバースのスムージング効果?が失われるらしい。で,FBXファイル形式でも出力し,検証した。それが図12のものである。表示が回転していることに注意して欲しい。ただ,問題は無い。

明確な根拠は無いが,スキャニバースの場合は,外部出力にはPLY出力よりも,FBX出力の方が適しているように思われる。両ファイル出力の精度を確かめるのに,前述のように,実用性の視点からして,4枚のラベルの表示の明瞭性を見るのがいいと思う。

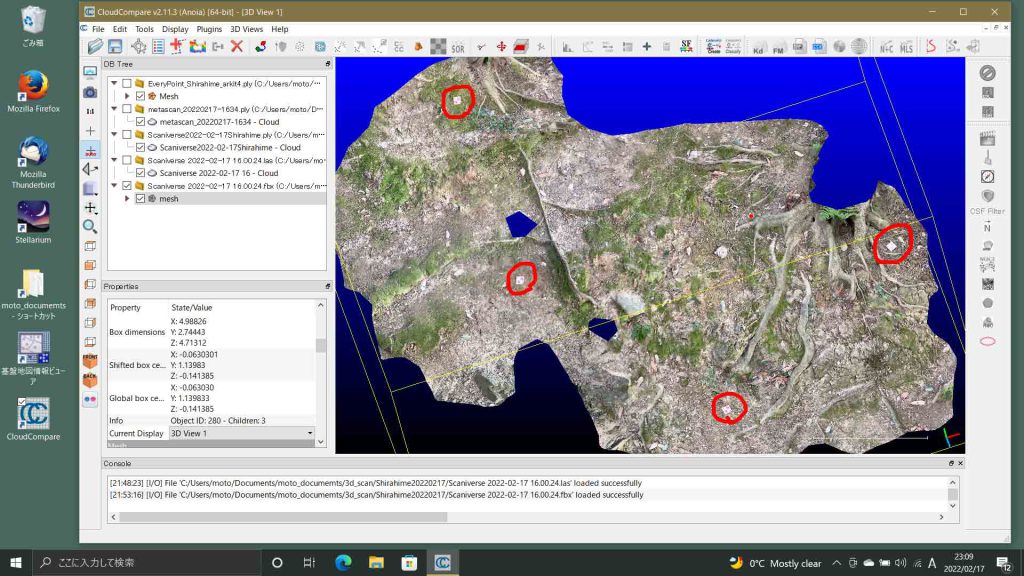

もちろん,今後の処理過程でPLYファイルがFBXファイルを上回る可能性もある。まだわからない。さて,図13_PLYファイル出力と図14_FBXファイル出力を比べる。拡大して見るとよくわかるが,明らかに図14_FBXファイル出力で4ラベルの認識が可能である。

今のところ,スキャニバースを使って3Dスキャン点群を得るには,PLYファイル出力よりも, FBXファイル出力が優れていることがわかる。肌理に大きな開きがある。

以上,スキャニバースは,丁寧に重ねてスキャンして高精細出力すれば,狭い範囲(この例では5 x 3 sq m)であれば,そして,FBX出力すれば,使用に耐えうると考えて良い。スキャンしてすでに感知記録された部分とされていない部分は,スキャン作業中,大変見易いので,使い易いソフトと感じられる。エブリポイントのように突然終了することも無かったと思われる。

本日実施した他の結果については,明日,記述したい。

以上,Feb. 17, 2022記。

5 エブリポイントARKit版は使え無い:白姫大明神,Feb. 17, 2022

エブリポイントがぼくにとって使えるかどうかは,ARKitモードに懸かっている。エブリポイントの押しは,EveryPoint LiDAR Fusion,であったが走査密度が粗く,室内も屋外も使えないことがわかった。すでに実現され未だ一般に公開されていない20mまでの撮影が実現しても,ぼくには意味がない。前述のように,岩間さんの3Dソフトウェア比較の記述の中にARKitモードには使用制限が無いとあって,エブリポイントを捨て去る前に確かめようと思った。エブリポイントは20分ほどだろうか,経過時間なのか,ファイルの大きさなのか,突然,切れてしまう。スキャン中,警告も無く,勝手に終了してしまうのである。これはもう致命的欠陥である。その欠陥はARKitモードには無いのか,これに関心があった。ARKitモードで室内のソファを撮影してノイズが多すぎて使い物にならないと判断したが屋外特に裸岩地帯での撮影に期待するぼくとしては捨てきれないところがあった。

で,エブリポイントのARKitモードは二種ある。

最初,ARKit Lidar Points,を試した。図15と図16に示したように,Scan Densityを設定,Smoothing Depth Map設定オン,confidence filterをhighとして撮影したのである。図16ではワイアーフレームが表示されている部分が撮影済みの部分と思われるのであるが,実際に曇り時々晴れの天候下のフィールドであっても,見えにくい。右上の窓には感知された程度が表わされている。濃いオレンジが感知されブルーが未だ感知されずといったところであろう。とはいえ,10分ぐらい経過したであろうか,突然シャットダウンした。これは使えない。

図17 ARKit Lidar Mesh

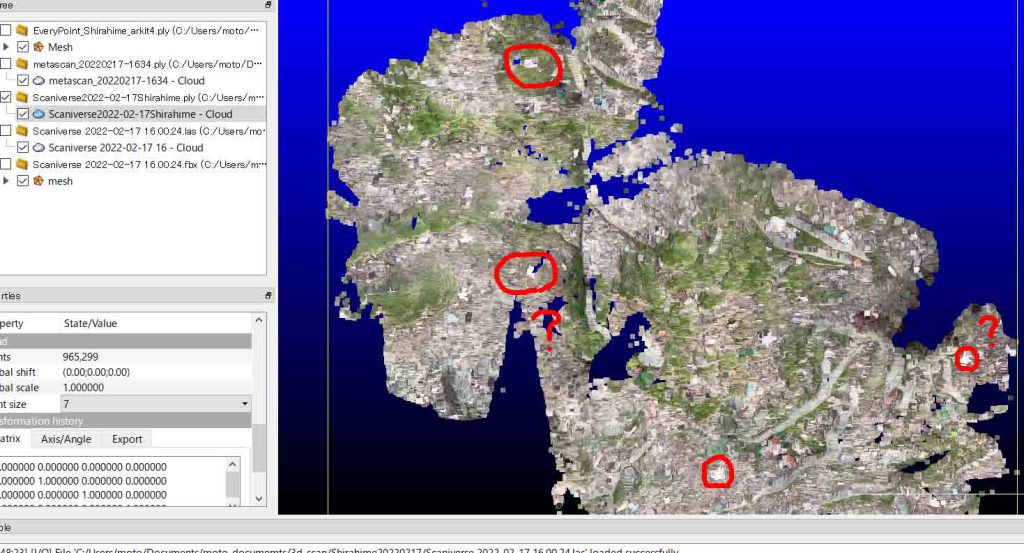

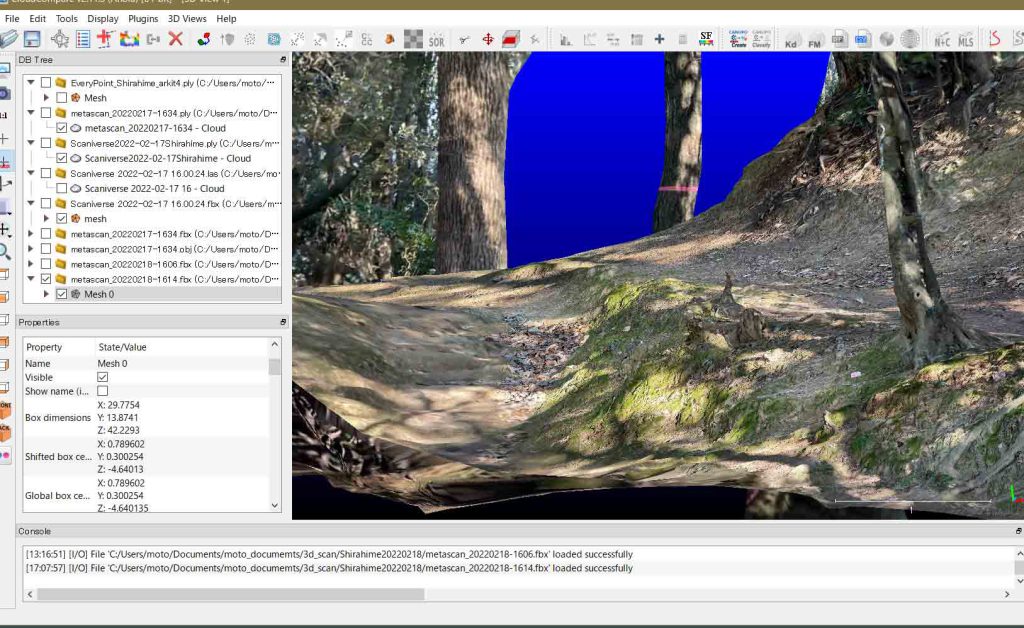

残りのARKit Lidar Meshはどうか。図17のように,撮影時はwireframeを選択したが,見にくいので途中,Meshに変更した。これは,いわばオレンジの雲の中に居るような表現で,感知されたところはどんどんオレンジになって行く。感知が終了していないところは黒い渦のようになっていて,その部分の周囲にiPhone 12 Proを巡らすことでその渦がオレンジの雲に変わる。映像は見えないがスキャンする上では支障はなく,むしろわかり安い。これは突然のシャットダウンは無かったので使うことは可能とは思われる。そして出来上がったのが次の図18である。全域のスキャンが可能であった。距離20mほどか。全域を示すと緑色だけしか見えないために,部分拡大図を示している。スキャニバースでは,例えば図14のように,木の幹は像を結ばなかった(設計上,抜く形か)が,この図18では,幹も現れている。

フレームワーク表示はCloudCompareによるものであるが,その密度は地形ではなくて,スキャン密度に対応しているように見える。地標の再現を主とするものではなく,スキャンの軌跡が表現されていると言えるように思う。ぼくの目的,つまり,自然地形を手許に再現したいという意図からすると,この設計思想は外れている。メッシュデータなので,pointのrgb情報が無いのは当然なんだろうけど,これもぼくの使用目的からすると,致命的である。

以上,当初Nature Scientificかの技術レポートで,EveryPointの地形計測ソフトウェアの優位性を感じた次第であったが,誤りであった。エブリポイントappは,ぼくのiPhone 12 Proから,削除する。

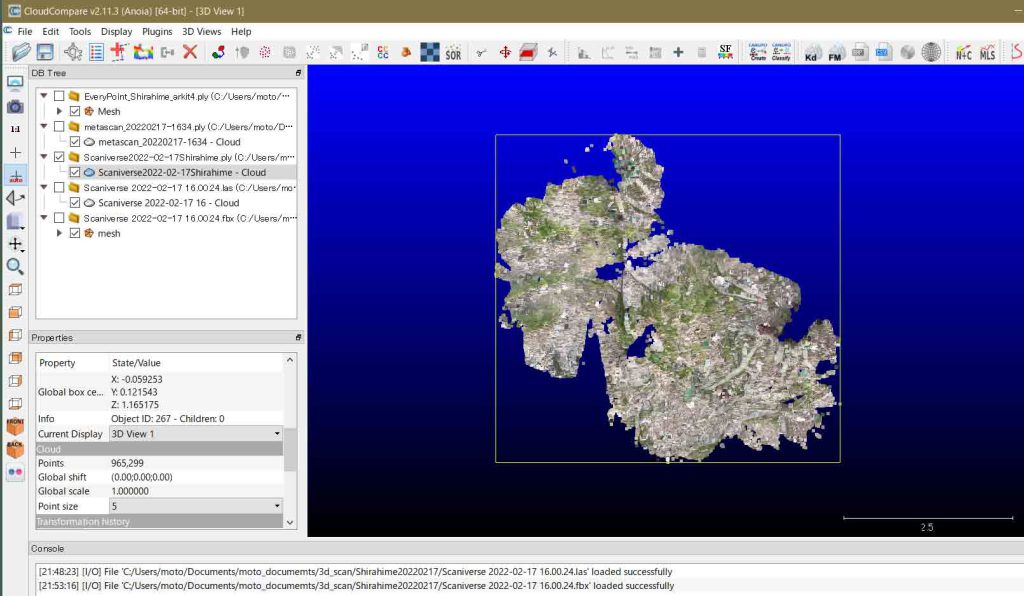

6 Metascanは他のアプリとは一線を画する:白姫大明神,Feb. 17, 2022

LiDARモードと写真モードがある。この日はまず,LiDARモードで広い範囲を撮影した。

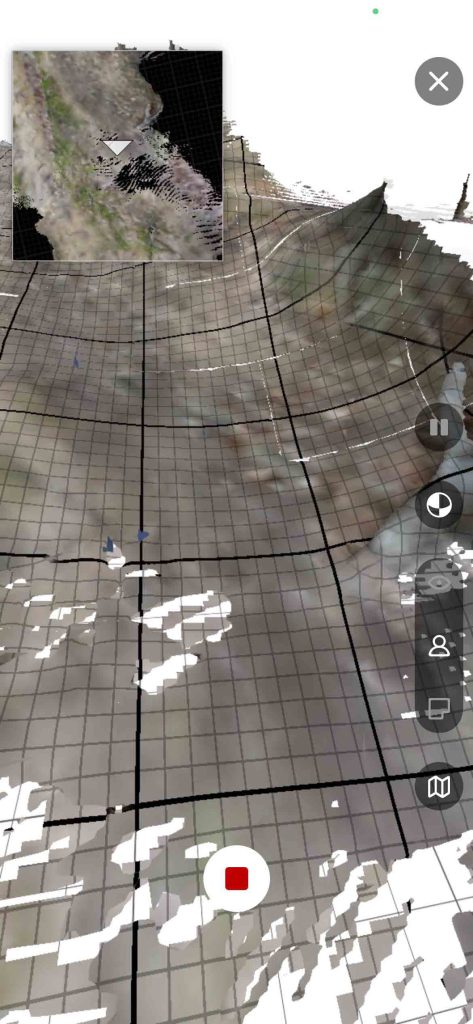

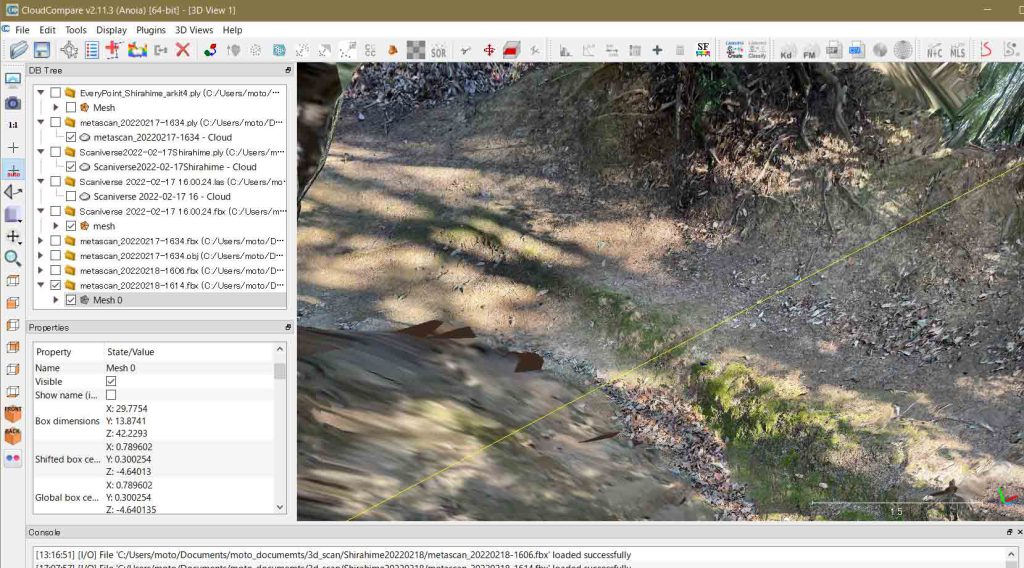

図19はLiDAR撮影をしている際の画面である。左上に小窓があって,この時までの撮影した範囲が示されている。確認しなかったが,磁北をiPhone 12 Pro画面の上方にしているかと思われる。この中の白い△は現在位置で,向いている方向を示す。画面右の最も下方のアイコン部分をクリックするとこの小窓が撮影中,継続することになる。

撮影は一回きりではなく,画面を見ながら白い部分が無くなるようにiPhone 12 Proを移動してゆくので,この小窓は,ナビゲーションに非常に有効である。この図19には現れていないが,紺色の小片が出現することがあり,これに対しても消失すべく,舐めるようにiPhone 12 Proを移動するのである。すでにスキャンが確定した部分でも図19での太いメッシュ線が白く現れることがあり,この方面にiPhone 12 Proを向けると消えてくれる。

図20は,高精細モードで保存した結果が出ているMy Scansの画面である。右のものは自宅室内で初めてスキャンしたもので,左のものが屋外で初めてのスキャンファイルである。1114MBとあるから,1GBとかなり重くなっている。出力する際には,ASCIIファイルなどの形で実施するのでそんなに重くはならないが,iPhone 12 Proの空き容量に将来圧迫を来すサイズと言えるので,随時削除してゆく必要がある。ぼくのiPhone 12 Proで,設定>一般>情報を今見ると,容量: 256GB,使用可能: 208.43GBとあるので,後者の200GBが現在の空き容量なのだろう。

なお,このメタスキャンのLiDAR使用効率はかなり高い印象である。スキャニバースではiPhone 12 Proのヘッドから手前側だけがスキャンされる印象でスキャン力も弱い感じがする。メタスキャンのLiDAR利用は,エブリポイントに近いが,更に面的に力を発揮している印象がある。バッテリーの消費も大きくて,昨日Feb. 17はバッテリーを省電力モードするようアラートが来た。何とかセーブまで持ちこたえることができた。バッテリー充電器は今後は持参した方が良い。メタスキャン,頼もしい。

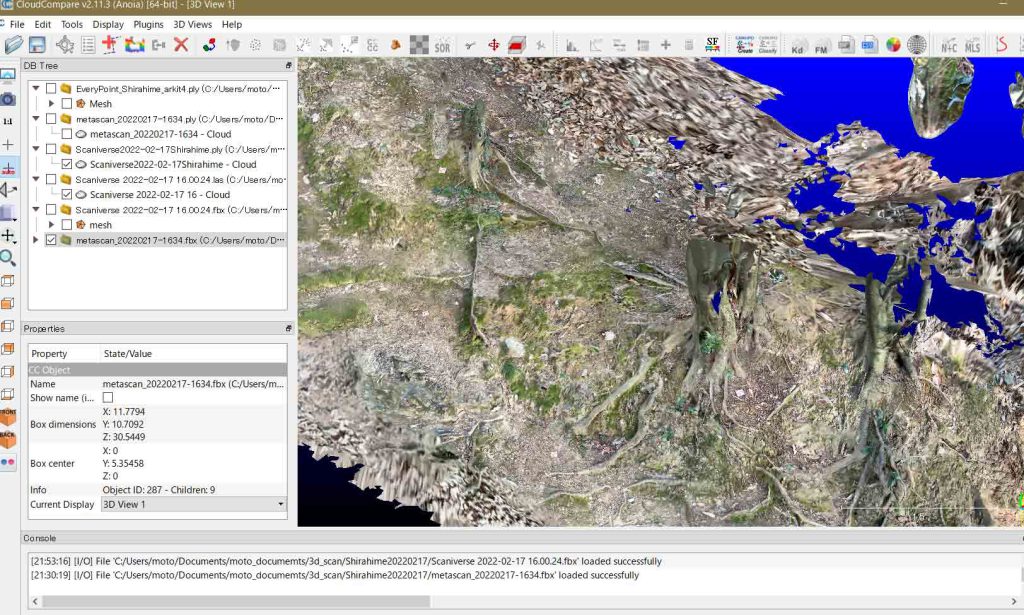

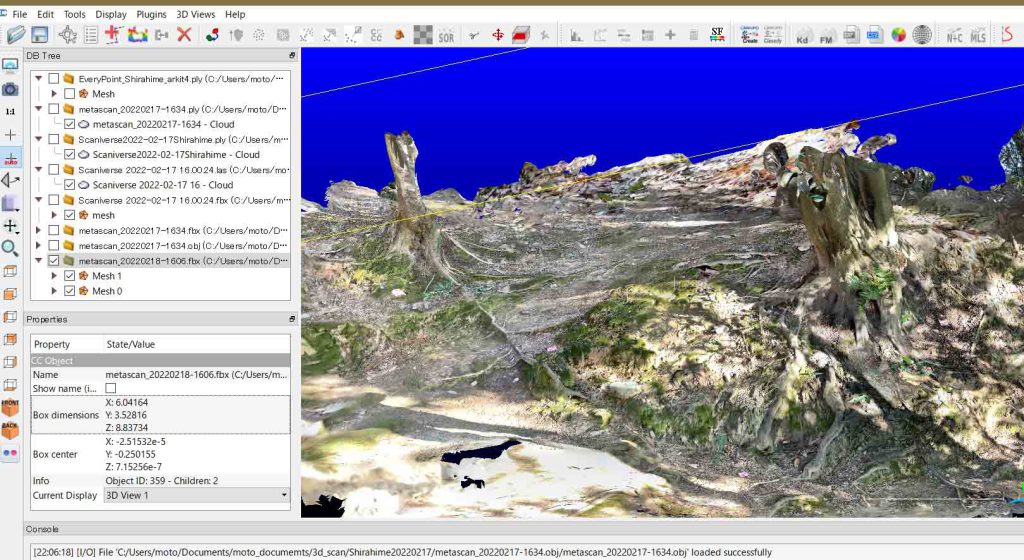

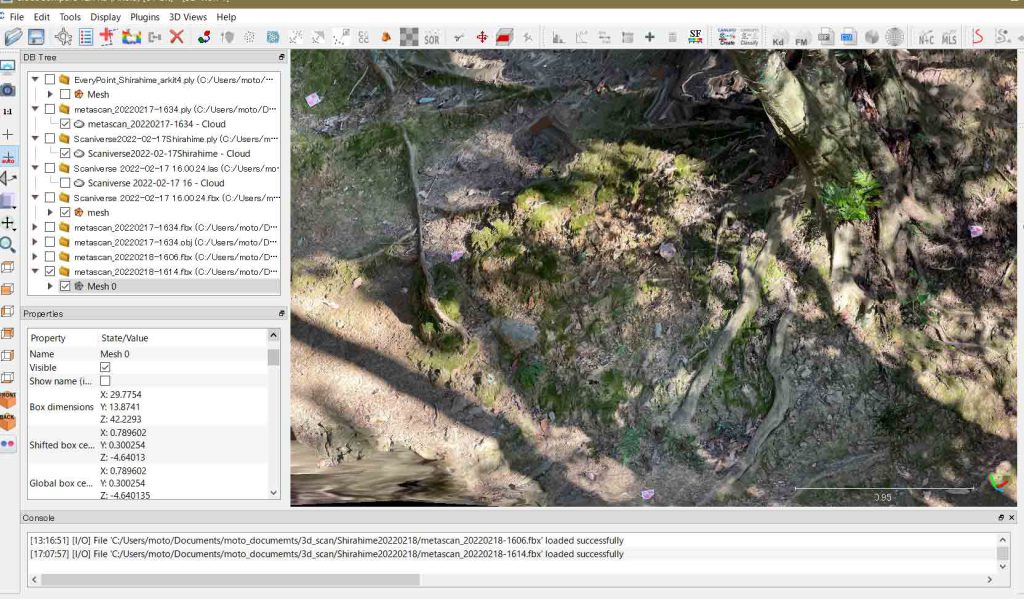

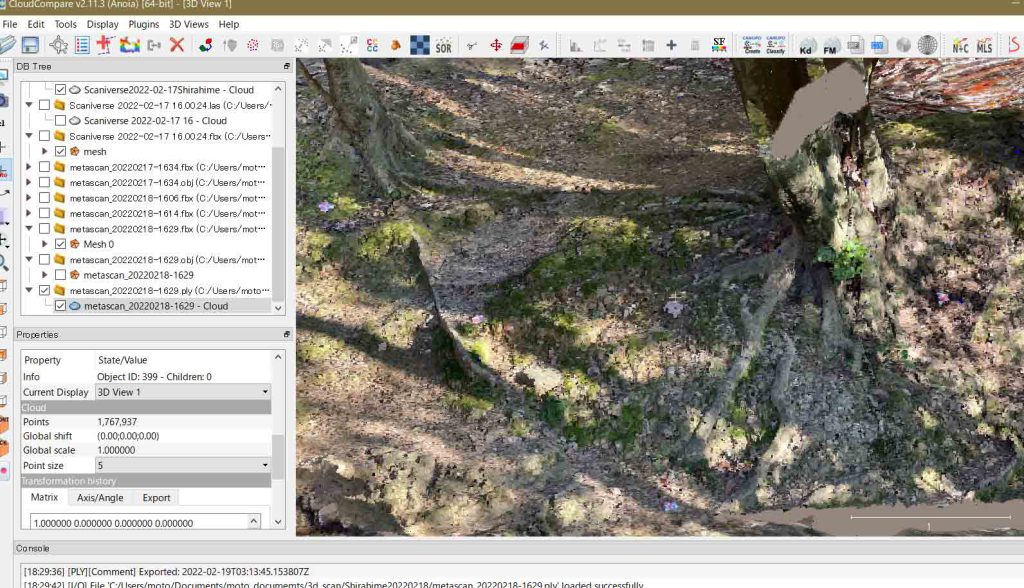

初めてMetascanのLiDARモードで屋外を撮影した。有料オプションで保存し,PLYファイル出力した。白姫大明神裏の勝尾寺への参道であり,最も広くスキャンした。不連続もなかった。図21ではラベル4付近を切り取っている。スキャニバースで撮影しFBXファイル出力した図14と解像度は変わらないが,立体感は,このメタスキャンの方がいい感じで,かつ,木の幹も再現されている。絵作りの点でも立体感でも,有料ながら,最も優れているのである。

MetascanのFBX出力の方はどうだろうか(図22)。図21のPLY出力に比べて画像がクリアな印象である。ラベルの解像度も多少高いようだ。

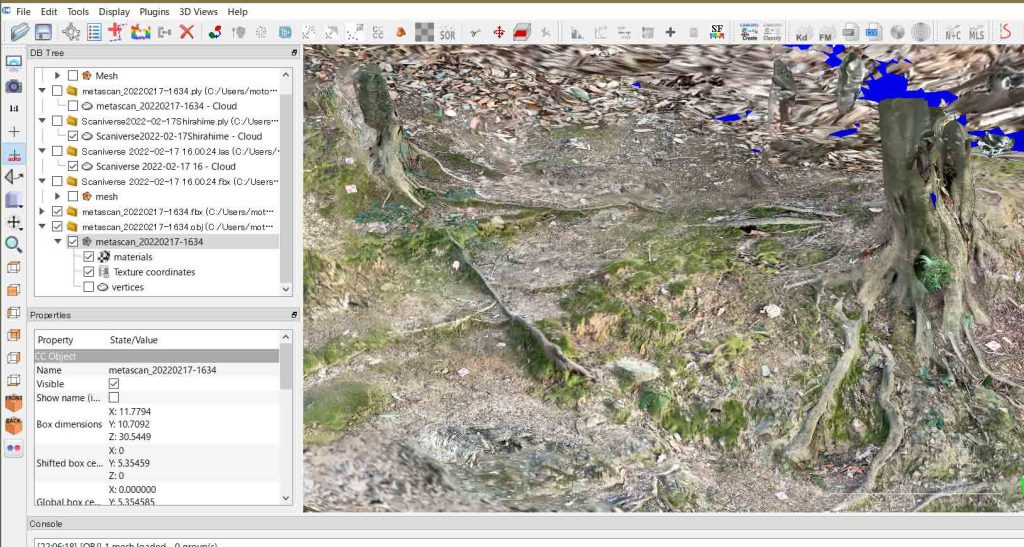

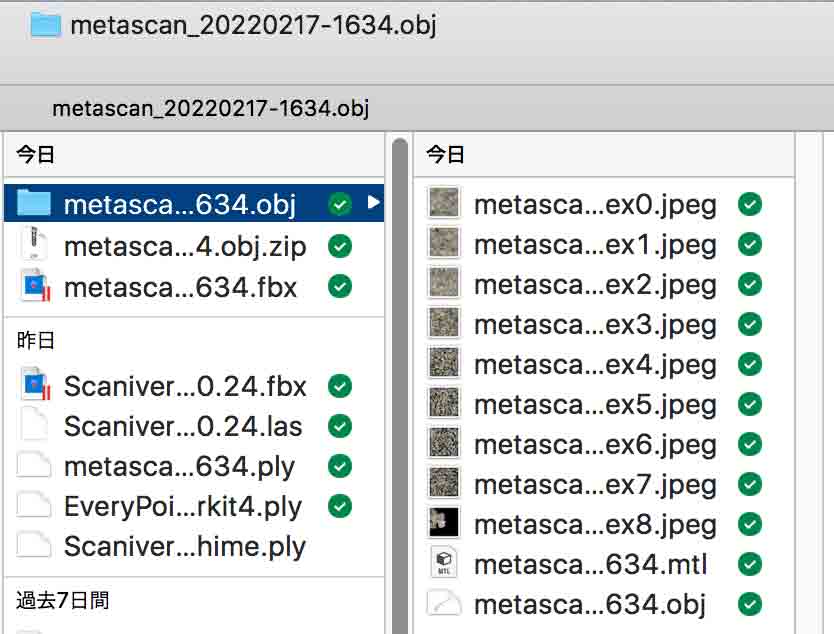

さて,Metascanでは,図20で見えるように1114MBのファイルが,PLYファイル出力されると39.5MB,FBXファイル出力されると45.4MB,そして次に示すOBJファイル出力されるとFBXファイルとほぼ同じく45MBになる。図24のように,OBJファイルはobj.zipという形で出力される。CloudCompareで読み取るには解凍しておく必要がある。解凍すると,図24のようにobjファイル以外にmtlとjpegファイルがある。CloudCompareで読み取ると,図23のように,materials, Texture coordinates, verticesが作成される。このクラウドコンペアの表示には直接はつながらない。

FBXファイルとOBJファイルとの間ではほぼ,肌理の細やかさの点で違いは感じられないので,今後は,分析の際に選択すればいいと思われる。

以上,Feb. 17, 2022の実験の整理は終わった。結局,狭い範囲で問題なく,目線より低い場所が主であれば,スキャニバース。広域に対応し高精度で,目線より高い場所もカバーしたいのであれば,メタスキャンである。メタスキャンはiPhone 12 Proのヘッドよりも30度ほど上までスキャンできるので,ぼくの目の高さよりも高い構造物に対して,スキャンできる。これは凄い味方になる。現在,メタスキャンの一週間お試し期間にある。もう少し触ってみたいと思う。スタンダード出力ならば無料なので,フィールド調査の際に月会員(780円/月)になって,高精度を使わせて頂くという形がベストであろう。

今日,Feb. 18には,更なる実験をした。1時間半ほどであるが。実行したことは次のよう。

1 この二日とほぼ同様の場所にラベルを4個設置。この付近で,メタスキャンを実行しスタンダード出力した。有料の高精細モードとどの程度の違いがあるかを調べたかった。

2 写真測量を実施。どのように写真が自動で撮影されるのか,と想像してたのだけど,自分で撮らんと行けないのね。考え直した。当然だわなあ。枚数が左下に出るわ。最低20枚撮れというメッセージがあって保存もできないのだ。始めにしては駄目だけど,最も長い距離を前に歩いて,写真は右横の斜面を狙いつつ,2ステップ毎に撮影した。さて,どうなっているか。

撮影の後,高精細で出力。uploadingが始まって結構長い。そして,calculationだったか,そしてprocessingになる。この時にはiPhone 12 Proで他のことをしてもいいよとあるので,何をしたいのか録音をした。これが終わると,scan processed,と表示される。coninueというボタンが出るので,これを押すと,新たに写真が撮れる。

3 4枚のラベル付近を高密度?に撮影した。斜面に向いて蟹歩きをした。60cm間隔ぐらいで撮影した。そして高精細で出力した。また結構の時間がかかった。これで一応,写真は終わる。計2ファイルだな。どういう形でファイルが出来?,CloudCompareにインポートできるのか,未だわからない。

4 写真では大変なので,LiDARでマージのスキャンマップを作成することに。つまり,下からラベル4枚の場所まで進み,次にそのラベル4枚の場所をダブって撮って上の方へ。移動距離としては長くない。計2ファイルが作成された筈である。

以上,Feb. 18, 2022記。

7 凄腕Metascanを理解すべく:白姫大明神,Feb. 18, 2022

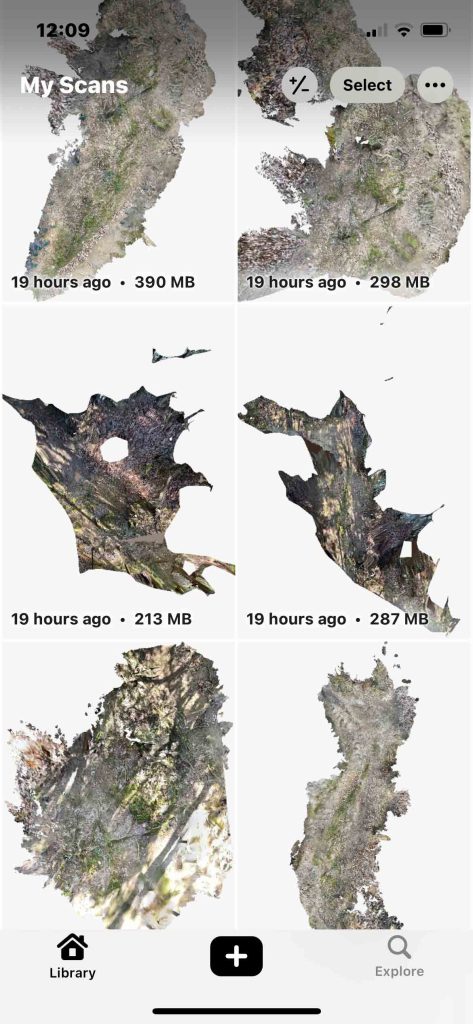

図26には第6章で述べたメタスキャンのファイル群が並ぶ。LibraryはMy Scansと呼ばれる。現在から遡る日時間が示される。上段左が最新,次が上段右,次が中断左,という訳である。ファイル容量も示されている。

このうち,下段左だけがスタンダード出力(無料該当)したものである。スカスカ感はこれだけには感じられる。

中段の二枚が写真測量のもので,高精細出力したもので,最も密な感じがする。上段の2枚と下段の右はLiDAR撮影して高精細出力したものである。

My Scansには,LiDAR撮影のものなのか,写真撮影のものなのかの情報は記されていない。

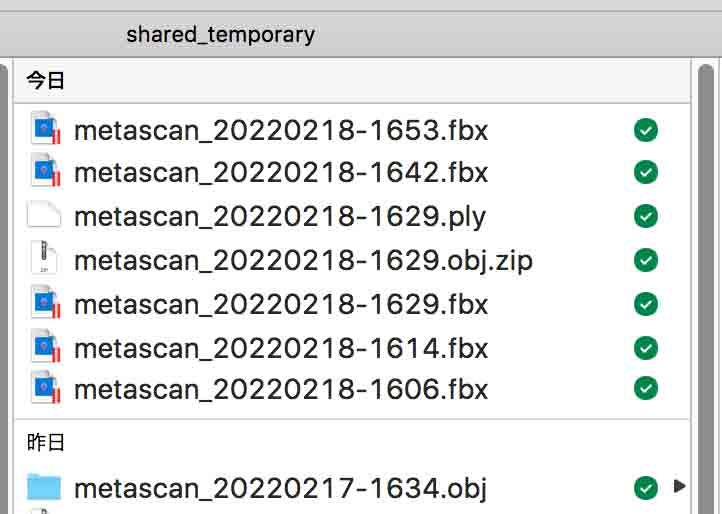

図27はmacのファインダーでのドロップボックス共有フォルダー部分の切り取りである。メタスキャンのファイル名は自動で作成される。エブリイポイントは自分で名付けなければならないというか,命名の自由度があるのだが,ユーザーへのその自由度は不要と感じられる。メタスキャンの自動命名は優れていると思う。どういうシリアル番号なのかわからない。使用開始はFeb. 16, 2022であるが,これには,metascan_20220216-1922という名称が振られていた。同日の撮影では確実に増えて行くので撮影順を知る上でありがたい。スキャニバースは日付のあとに時分秒??.??.??が追加される。とここまで書いてきて,metascanの最後の四桁の意味がわかった。例えば,1629は,16時29分,たぶん撮影終了の時刻だなあ。

7.1 LiDAR撮影,スタンダード出力,の精度

四枚のラベルを置いた付近をLiDAR撮影しスタンダード出力した。その結果が次の図28である。

図22や図23と比べてほとんど遜色が無い。ラベルもハッキリ見える。CloudCompareで拡大して確認したが,高精細モードで出力したものと違いを感じないのである。それで,次のメタスキャンのサイト Terms of Use を調べてみた。FAQを次にそのまま掲載する。特に僕が参考になると思ったものを強調している。

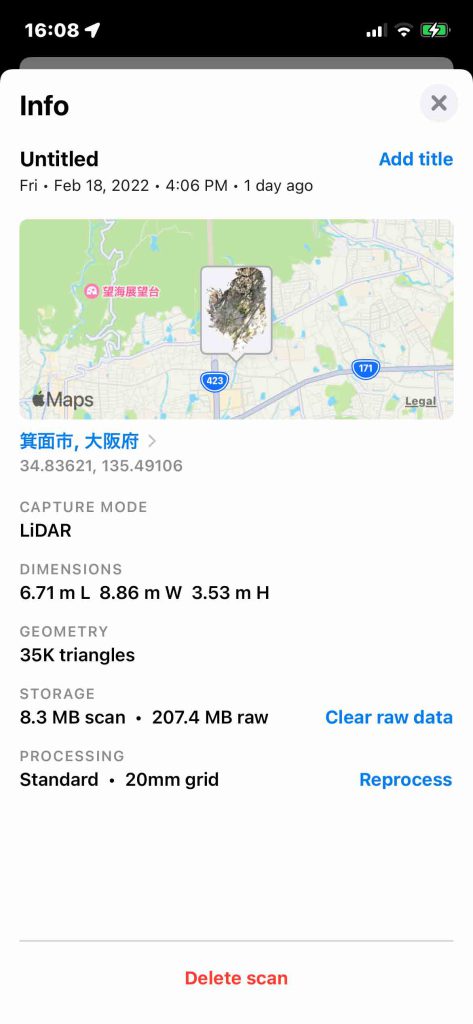

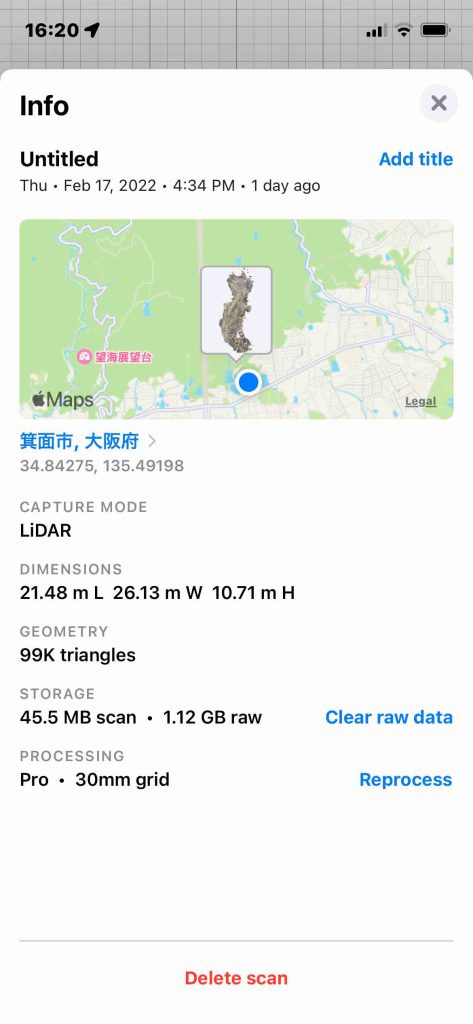

その前に,図29には,2月18日の初めにスタンダード出力したmetascan_20220218-1606,図30には2月17日に高精細モード出力したmetascan_20220217-1634の情報ウィンドウを示す。いわば図29は無料版,図30は有料版である。

ぼくのiPhone 12 Proでは,このアプリはMetascanと表示されているが,次に示すメーカーの文書からすると,一週間の試用期間前にキャンセルしないのであれば,Metascan Proになるのか,わからない。図29と図30で,スキャン範囲に違いはあるが,trianglesの数は3倍で,raw file容量は5倍もある。

両図のスキャン場所は同じであるが,Google map表示では,何故か図30は正しく,図29は結構のズレがある。

引用開始————————————————

Contact Us

We’re happy to answer your questions. Send us an email, ask a question in our community Discord server, or use the app’s Contact Support feature.

Frequently Asked Questions

What devices does Metascan run on?

Metascan supports any iPhone or iPad from 2015 or later that runs iOS 14. LiDAR Mode requires a device with LiDAR Scanner, such as an iPhone 12 Pro or iPad Pro 2020.

Does my data stay on my device?LiDAR Mode processes completely on-device, while Photo Mode uploads your photos to our photogrammetry server for processing. The photos are deleted from the server as soon as your model is processed.Sharing a scan using Upload Scan uploads it to our web server. You can delete it at any time using Delete from Cloud in the app.

What does the Metascan Pro subscription give me?Available as either a monthly or annual in-app subscription, Metascan Pro unlocks the following features:Export to all supported file formats.Highest resolution LiDAR scans.Process 150 photo scans every 30 days.Metascan Pro has a one week free trial period.

What file formats does Metascan Pro export to?

Metascan currently supports:

USDZ is an open standard, supported natively on iOS and macOS.

FBX is a closed format, created by Autodesk and widely supported by 3D software applications and game engines.

OBJ is a simple text-based format which is supported by almost all 3D software. Metascan stores the OBJ file and its JPEG textures in a ZIP file when exported. テキスト編集にはこのファイル形式がいいような?

glTF is an open standard format for sharing 3D data on the web. Metascan uses the .glb format to embed all data in a single file.

PLY is a simple format used for sharing point cloud data. Metascan stores the 3D position and color data in binary.

LAZ is a widely used format for sharing point cloud data that is georeferenced so can be imported into a GIS system such as QGIS for analysis. 未だわからないけど,iPhone 12 ProのGPS機能を使って何らかの座標認識が行われるのかも知れない。その座標系は国土地理院のものではない。global boxって変なサイトもある。

When exporting multiple scans, files are stored in a single ZIP file. Contact us if you’d like to see additional formats supported.

What units are exported models measured in?

All coordinates are expressed in units of meters.

How are model textures exported?

Texture maps are stored in one or more square RGB images at maximum 4096×4096 pixel resolution and compressed with JPEG to 92% quality level using 4:2:0 Chroma subsampling.

How do I take better LiDAR scans?

Taking good scans requires practice. Here are some tips:

Scan bright, well-lit areas and try to avoid capturing small objects.

Make sure your camera lenses are clean. Wipe them with a cloth before starting.

Check that the tracked feature points (colored dots) appear stable before you start scanning.

Aim to keep between 0.5 to 3.0 meters between you and the surface you're scanning.

Avoid moving too quickly – it causes camera motion blur.

Avoid transparent, shiny or reflective surfaces such as windows, metal or mirrors.

Avoid any moving objects, people or animals.

How do I take better photo scans?

Photo Mode uses photogrammetry which relies on matching image features between photos to estimate distance. Here are some tips to improve your scans:

Non-transparent, unreflective objects with varied surface textures scan best.

Capture all sides of your object in a series of orbits.

Adjacent shots should have 70% overlap or more for alignment.

Minimize motion blur by holding your device steady while taking a photo.

Make sure you have even, good lighting and a stable environment for scanning.

If scanning outdoors, cloudy days work best.

引用終了————————————————

7.2 写真撮影,高精細出力

写真測量はこれが初めてである。前章で,「始めにしては駄目だけど,最も長い距離を前に歩いて,写真は右横の斜面を狙いつつ,2ステップ毎に撮影した。さて,どうなっているか」としたものである。raw fileは287MBで,fbx出力した。

この図31は悪く無い。写真だけにラベルもLiDAR画像に比べると一番良い。図32はより奥に入ったところである。ここで見える小さな崖に注目して急いで撮ったようで,この崖の手前の道路は流れている。小崖に注目して,2歩間隔で写真を撮っていった結果がこれである。道路に垂直方向にカメラを構える意識があったと思う。前掲のメタスキャンのサポート情報からすると,LiDARのように舐めるように全像が入るように撮影をする必要があるように思われるのである。

撮影した写真は撮影後,iPhone 12 Proからメタスキャンのサーバーにアップロードされ,写真測量幾何学で計算されて,その結果がiPhone 12 Proに戻ってくる。ネット環境が無いところではこの作業はできない。恐らく,ネット環境がある場所に移動すれば,そのあと,実行されるものと想像される。次回,その点を意識して,撮影したいと思う。この撮影の際,日差しが時々あって,その影響は考えられたが,予想以上に,よく撮影されている。

図31では立体感が得られないので,少し回転して次のスクリーンショットを撮影した。

次に,「4枚のラベル付近を高密度?に撮影した。斜面に向いて蟹歩きをした。60cm間隔ぐらいで撮影した。そして高精細で出力した。また結構の時間がかかった」。で,写真の場合の出力の質を調べるために,FBX, OBJ, PLYの三種で見た。図33はFBXファイル出力である。これまでの最高の画質である。回転したりしてみたが立体感も一番優れている。空中写真であれば,オーバーラップを大きくすると,過高感は低下するが位置情報があるので,そうはならず,オーバーラップを70%ぐらいにするのが効率的と考えれば済むことである。そして必ずしも平行軸である必要が無いのではないかと想像している。いわば撮影軸を回転してゆく,という発想でやってみたいと思っている。

図34はOBJ出力したものである。不確かだがOBJの方がより肌理が細かいように見えるがわからない。

ポイントサイズを5にしている。PLY出力は明らかに肌理が粗い。LiDAR同様,写真測量幾何学でも,OBJかFBX出力が適当である。

おわりに

Feb. 18, 2022撮影したLiDAR画像は図26と図27の残り2件である。これらは二つの点群のマージする実験に使おうと思う。次のサイトに続く。 二つの3Dスキャンマップを繋ぐ

以上,Feb. 19, 2022記。