iPhone 12 Proで3Dスキャン 3D LiDAR scanning with iPhone

はじめに

まずは,be氏とのドローンを使った地形測量を体験して,年金生活者ゆえに機器にもお金をかけることもできず,iPhone 12 proを使って,微地形の3Dスキャンがしたいと思っただけのことである。

昨年3月,徳之島の海岸調査中,潮位計測をしていて,屈み込んだ際に,サンゴ礁のグルーブに前ポケットからiPhone 7 Plusが落下。素っ裸でグルーブに入って何とか回収。その後も問題なく?使えて,帰阪。ちょっとiPhone 12 Proを調べたら,( i 小文字が好きなアップル)LiDAR, Light Detection and Ranging●光強度方向探知ならびに測距, 機能が搭載されたとのことで,7+は次男に譲って,May 20, 2021,アップルストアに注文した。その後,全く使わず放置していたが,次回の調査は一人で行くことになりそうで,装備の点から,iPhone 12 Proの有効性,限界を知りたくて,調べ,実験することにした。

1 iPhoneで始める3Dスキャン生活

iwama2021年10月10日さんから

ネットでちょっと調べると英語圏に限定されるような印象であったが,このサイトでは実験する際の情報が優しく記されている。

a 機器構造: リンクにあったApple iPad/iPhone搭載「LiDARスキャナ」について調べてみた はぼくには難しいが,AppleのLiDARは,発光には近赤外線が使われ,モバイル装備としては,屋外に強く長距離性能に長けたdToFが採用されているとある。

b 特色: ①LiDARスキャンのレンジは5m程度,②スキャン品質はそれなり,③広域のスキャンでは高低差がある場合は苦手。

c 推奨アプリ

価格:610円(買切り)

アプリのヘルプ:公式チュートリアル:https://www.trnio.com/tutorial

日本語マニュアル:https://note.com/iwamah1/n/nd6fb91ea7738

対応デバイス:iOS11.3以上のiPhone/iPadに対応(推奨:iPhone6S以上)

出力形式:メッシュ:OBJ

Sketchfabへのアップロード:〇

アプリのリンク:https://apps.apple.com/us/app/trnio/id683053382

公式サイト:https://www.trnio.com/

公式Twitterアカウント:@TRNIO

TrnioはiPhoneやiPadで撮影した写真をクラウドにアップロードし、それを元に3Dモデルを作成してくれるフォトグラメトリアプリです。ネットに繋がって写真が撮れるiPhoneならどの機種でもOKです(ARkitモードを使用する場合はiPhone6S以上が必要)

使用法については,iwamaさんのTwitterサイトにある。

Trnio 3D Scannerを使ってみよう!

iPhoneとTrnioでスキャンした3DモデルをDOOR NTTに持っていく方法を書いていくよ!

ここで使用されているBlenderソフトはフリーでWindowsだけでなくMacでも対応している。【2021】Blender(ブレンダー)の使い方を日本語でわかりやすく解説

LiDARと比べるとかなり面倒ではあるが,5mの限界を超えることができる。

価格:無料

アプリのヘルプ:公式チュートリアル:https://scaniverse.com/support/

日本語マニュアル:https://note.com/iwamah1/n/nc8a5427157ef

対応デバイス:iPhone12Pro/13Proシリーズ、iPad Pro(2020/2021)

出力形式:メッシュ USDZ,FBX,OBJ,GLTF,STL/点群 PLY,LAS

Sketchfabへのアップロード:〇

アプリのリンク:https://apps.apple.com/jp/app/scaniverse-lidar-3d-scanner/id1541433223

公式サイト:https://scaniverse.com/

公式Twitterアカウント:@Scaniverse

使用法については,iwamaさんのTwitterサイトにある。

こんな適当ムーブでも3D出来ちゃう訳なんですよシリーズScaniverse編

d 不要なデータを削除: iPhoneで3Dスキャンした場合の最終3DモデルデータはLiDARスキャンで平均15MB、最大50MB程度(最高品質で処理した場合)、フォトグラメトリだと平均nnMB、最大nnMB(最高品質処理)となります。RAWデータは結構重くてLiDARスキャンだと50~300MB、フォトグラメトリモードだと50~400MB程度となります。RAWデータを使用するのは3Dモデルを構築する段階のみなので、モデル構築に問題がない場合はRAWデータのみを削除することが可能です。そのため削除前は200MBあったデータ容量も15MB程度まで減ります。

e 撮影対象の是非:

iPhone3Dスキャン全般に向いている物:

・岩や石像ざらざらとした質感のもの

・痛車や壁画などの模様がはっきりしているもの

・形状があまり複雑でないもの

・汚れが多いもの

iPhoneフォトグラメトリに向いていない物

・陶器製やプラスチック製の物体など表面がつるつるしているもの

・影になっている部分(環境によるので一概には言えないですが…) ← 曇りの日がいい。

・白飛びしやすいもの

iPhoneLiDARスキャンに向いていない物

・サイズが小さい物(30㎝×30㎝以下のものは失敗することが多い)

・自分より背が高い物(高い建物などは難しい)

・起伏の激しい地形 ←微地形には向いていないかも?

f 3Dスキャン時の安全対策:

①スキャン前に周囲の段差や人などの周辺確認

②スキャン中は画面を注視しない

g スキャン時の心得:

1 スキャン対象とスキャン対象の周囲の障害物の有無やスキャンルートを選定。

2 同じ箇所を2回以上スキャンしない。iPhone LiDARはスキャンする毎に誤差が蓄積。

3 スキャン中の移動はゆっくりとスムーズに。急な方向転換は絶対にNG。すり足でゆっくりと移動。

4 蛍光灯や太陽等の非常に明るい物体にiPhoneを向けすぎるとiPhoneの自己位置推定機能にエラーが発生。

5 出来る限り脇を固めてiPhoneがブレないように。

6 鏡や鏡面仕上げされた金属などがスキャン範囲にある場合は出来る限り布で覆う。

7 屋外でスキャンする場合は出来る限り曇りの日を狙う。薄暗い時間帯や晴天の日は上手くスキャンできないことが多い。

8 連続でスキャンする場合はデバイスの温度に注意。特に直射日光下での場合は一瞬でオーバーヒート。対策としてスマホカバーを外したり日傘などで直射日光を遮る。

2 Evaluation of the Apple iPhone 12 Pro LiDAR for an Application in Geosciences

Nature Scienceに掲載されたgeo-toolとしての評価があった。PDFも提供されている。

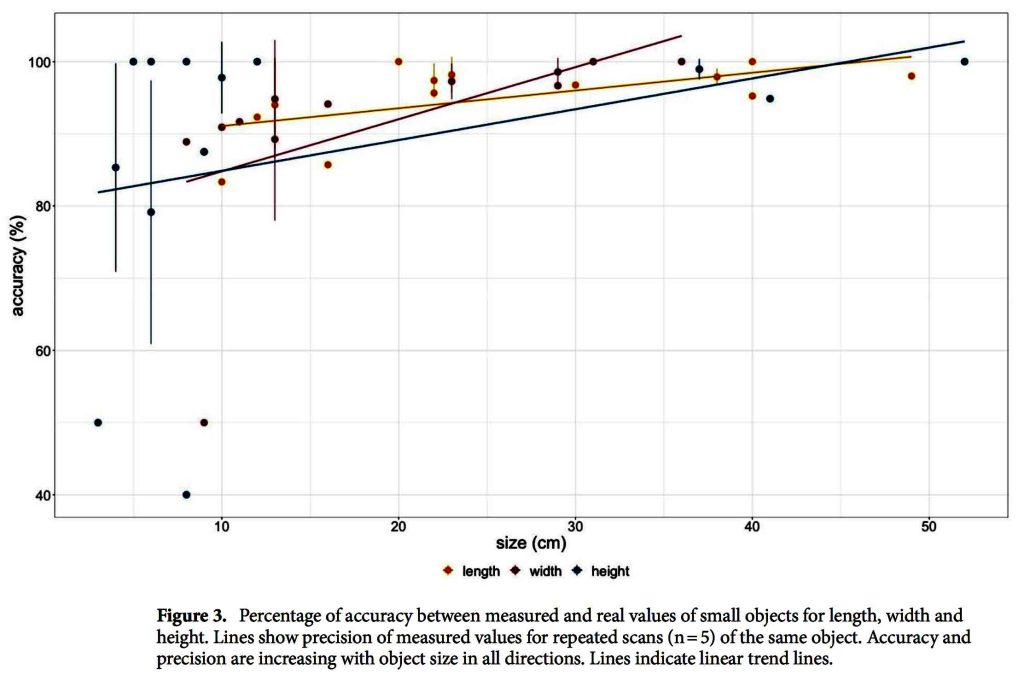

Traditionally, topographic surveying in earth sciences requires high fnancial investments, elaborate logistics, complicated training of staf and extensive data processing. Recently, of-the-shelf drones with optical sensors already reduced the costs for obtaining a high-resolution dataset of an Earth surface considerably. Nevertheless, costs and complexity associated with topographic surveying are still high. In 2020, Apple Inc. released the iPad Pro 2020 and the iPhone 12 Pro with novel build-in LiDAR sensors. Here we investigate the basic technical capabilities of the LiDAR sensors and we test the application at a coastal clif in Denmark. The results are compared to state-of-the-art Structure from Motion Multi-View Stereo (SfM MVS) point clouds. The LiDAR sensors create accurate highresolution models of small objects with a side length> 10 cm with an absolute accuracy of ± 1 cm. 3D models with the dimensions of up to 130 × 15 × 10 m of a coastal clif with an absolute accuracy of ± 10 cm are compiled. Overall, the versatility in handling outweighs the range limitations, making the Apple LiDAR devices cost-efective alternatives to established techniques in remote sensing with possible felds of application for a wide range of geo-scientifc areas and teaching.

長さ10cm以上であれば ±1cmの精度で測量できるということで,ぼくが今想定している研究対象の微地形については,厳しい感じがある。フィールの広がりとしては,海岸線沿いに距離130mで斜面幅は15m,高さは10mぐらい(Scanning of the entire coastal clif and the beach at Roneklint (length: 130 m,width: 15 m, height: 10 m)のものであれば, ± 1 cmの精度とあり,微地形そのものではなくて,広がりの視点で言えば,測量に問題がないということになる。

図3で,垂直幅height,横幅widthについては理解できるが,lengthはおそらく最大径のことかと思われる。なお,使用アプリ名として,3d Scanner App. 1.8.1, EveryPoint, SiteScape, Polyscanが上がっているが,主に3d Scanner App.が使われたようである。ただ,EveryPointとそのサーバーの使用について興味深い機能が紹介されているので次に示す。EveryPointでは,5m以内ではLiDAR測量がそれを超える範囲では写真測量が同時に実施されている。1.5mの撮影棒も使っているけど,画面を見なくてもいいのかなあ。

and recordings of the clifs were obtained with the ‘EveryPoint’ app by URC Ventures Inc. version 2.5 in the ARKit LiDAR Mesh mode. In that scanning mode, a mesh of the close surroundings (< 5 m) is generated based on the iPhone’s LiDAR sensor. At the same time, the app is taking a video with the iPhone’s camera. Data recoding is performed by walking along the beach close to the water line pointing the phone side wards of the moving direction towards the object of interest. Close surroundings like the beach are captured by the LiDAR sensor, whereas objects further away like the clif, are only recorded in the video. Both video and LiDAR mesh were uploaded to EveryPoint’s servers where their own photogrammetry algorithm is creating a point cloud out of stills cropped from the video and the LiDAR mesh. Te user can download the point cloud that combines images and LiDAR data as well as the source images when processing is done.

EveryPointのサーバー利用の費用については書かれていない。これはこのページの後ろで示したいと思う。なお,次のような記述があるので,世界測地系との対応についても,用意されているようである。

In between the scanning dates, GNSS tagging was added to the app’s functionalities.

追記 Dec. 7, 2022: このEveryPointをiPhone 12 Proにインストールして実査に使ってみたりしたためだろうが,この開発会社からメッセージが何ヶ月前かに届いて,今後の開発を中止するというようなことであった。

3 期待されるアプリとサーバーまたはクラウド利用について

これまでの情報では,期待されるアプリとしては簡便性では,Scaniverse,遠近両用の測量が可能なEveryPointのようである。何れもクラウドが用意されている。価格と契約条件が気にかかる。

Scaniverseについて————————————————

Scaniverseを使ってスマホで3Dスキャンをしよう! このページでは使い方がわかりやすく示されているが,座標系に係わる情報は全くない。アプリの使用は無料だが,高画質での出力には費用が発生する。低価格と思われるが。日常的なお遊びでは,このアプリは適当なものと思われる。

アップルストアでダウンロードしたが簡単にインストールできた。

EveryPointについて————————————————

これは日本のサイトには無いか。アップルストアでダウンロードしてインストールする際に個人情報の入力が必要である。PCのメールアドレスと対応パスワードの設定が求められる。インストールの際,メールアドレスとパスワードを求められるが,新規登録のコメントが下にあるので,ここから入る必要がある。PCのメールアドレスでの確認が必要であった。

EveryPointのVideo+LiDAR Fusionを使ってみた感想 というtomoさんのページがあった。使った感想のみ。まとめの感想が次。まあ,そうだろうなあ。

調整が必要なのはimgs(length)とm(max depth)で、いずれも大きくしすぎるとiPhoneのスペックが足りなくなり、アプリが処理中に落ちる。アプリが落ちないように、でもなるべく高精度モデルが作れるように、いろいろと試行錯誤した結果、600imgs(写真枚数)と20m(撮影距離)とするのがベストではないかと思っている。

3D Scan 【iPad / iPhone Proシリーズ】点群密度を変更可能!3Dスキャンアプリ「EveryPoint」の使い方 を次に読んでみようと思う。

以上,Feb. 9, 2022記。異常に鼻水が出続ける。

4 エブリポイントについては薄い情報

直近のリンクを見た。説明が懇切丁寧でわかりやすい。ただ,撮影した結果が示されていないので,説得性に欠ける。ツウィッターにエブリポイントから紹介されているコンテンツがあり,ぼくが関心が持てた二件を次に示す。

例1 A impressive scan of a stump scanned by one of our iPhone app beta testers @cretakano. The resultant point cloud is so dense that it looks like a solid surface. What could you do with dense point clouds of objects that you scanned with the iPhone in your pocket?

https://publish.twitter.com/?query=https%3A%2F%2Ftwitter.com%2FEveryPointIO%2Fstatus%2F1481066066311004160&widget=Tweet

例2 Over the summer one of our team members had a chance to hike Yosemite and capture this beautiful section of boulders and rock faces at Nevada Falls. Imagine using an iPhone for scanning rock formations for geological studies.

ただ,このエブリポイントのツウィッターコンテンツは,一般ユーザーが試用して厳選されているようで,ぼくがやってみないとわからない面がある。

前述の「EveryPointでは,5m以内ではLiDAR測量がそれを超える範囲では写真測量が同時に実施されている」という機能は,3D Scan 【iPad / iPhone Proシリーズ】点群密度を変更可能!3Dスキャンアプリ「EveryPoint」の使い方 によればまだ公開されていないとあるが,現在はどうなのか。もちろん,今,iPhone 12 Proで実行すれば済むことではあるが,エブリポイントの開発元のサイトで調べてみたい。

https://portal.everypoint.io このサイトはユーザーアカウントの管理用で情報は,下記のヘルプ以外存在しない。

EveryPoint Help

ユーチューブリンクがあるが最悪。センスゼロ。次の文だけでいい。大変参考になった。ゴチと日本語訳は筆者。

Scanning Tips

Avoid rotations in place – It’s easy to stand still and look around, but this doesn’t give good 3D results. Instead, keep your feet moving, and when you need to turn in a new direction, make sure that it’s an arc (back up and then arc if needed).

Avoid motion blur(被写体が動いたために生じるブレ) in the video – In indoor or dimly (薄暗い明かりが灯っている)lit environments it can be easy to have motion blur in the video (as the camera’s shutter is open for longer periods of time). Move a little slower and avoid shaking or moving the phone too quickly.

Try to keep diverse scene elements(多様なシーン要素) in view – The 3D reconstruction works best when there are a variety of unique, high-contrast objects in the scene. Avoid continually filling the camera’s field-of-view with entirely white walls, looking straight at the sky, etc.

Maintain strong connectivity between near and far views – When scanning a scene, we usually get the most complete results when you keep your distance from what you’re scanning and try to make sure that there are lots of unique things in view. To add detail to a reconstruction, you then can get closer at various parts, but you need to make sure that there is some unique object/texture in view in order for the image tracking to latch onto(しがみつく). By combining near and far views, you can try to get the best of both worlds: the far views of the whole scene help tie everything together and provide a nice skeleton of connectivity for the reconstruction, and the near views can add detail (as long as those near views are easily distinguished and share similar content with the far views).

Limited LiDAR range – The LiDAR sensor in the iPad Pro (or iPhone 12 Pro) only has a 5 meter range. So, while standing back to capture the whole scene can be really helpful, in order to test out the LiDAR you will likely want to get within 5 meters to see how it performs (you can check the live depth view in the corner of the app to see what is currently visible by the LiDAR sensor).

Variety of viewing angles – When scanning an object or scene, it’s best to view it from a variety of overlapping angles and distances. You want to maintain strong connectivity between those different views, but having a large variety is important in order to generate complete and accurate results. This is especially important for flat objects, as only scanning a flat surface from a single, constant distance will result in issues with the reconstruction.

ネットサーフィンをしたが,結局,EveryPoint Video + LiDAR Fusion,については,見つからなかった。また,改めて,EveryPoint,に関する情報も希薄であった。まあ,この種の情報に対する関心とビジネスが厳しいものであると感じた次第で,ある程度,クラウドなどの費用は負担したいと思うようになった。

5 エブリポイントを使う準備

3D Scan 【iPad / iPhone Proシリーズ】点群密度を変更可能!3Dスキャンアプリ「EveryPoint」の使い方 に示された手順をまずは確認したい。

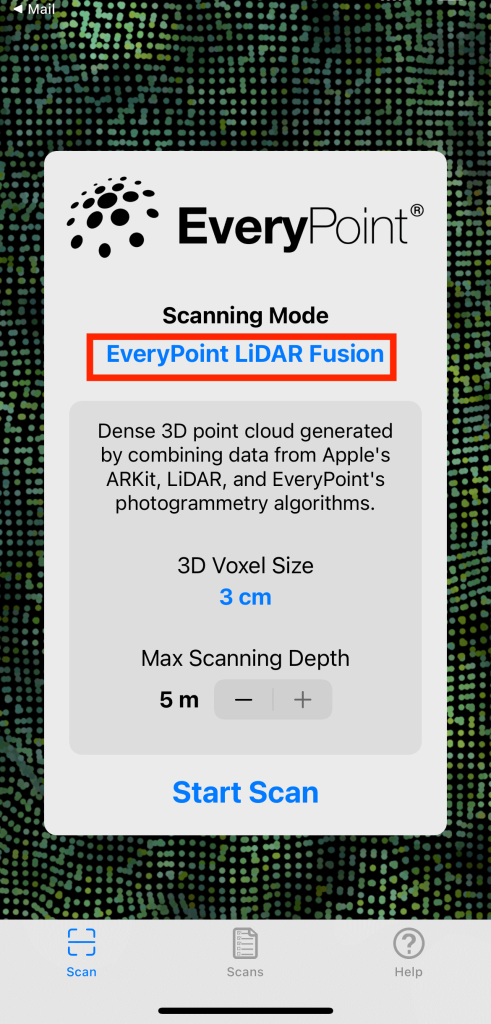

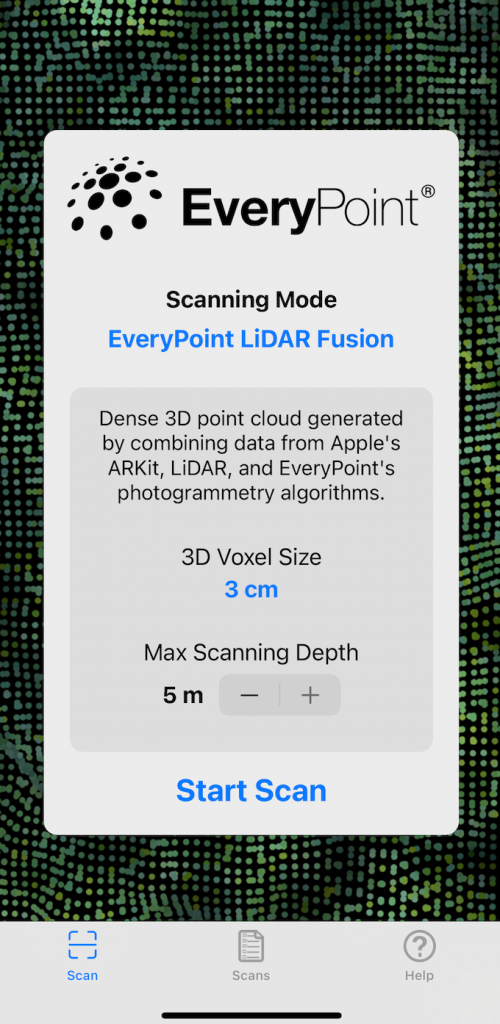

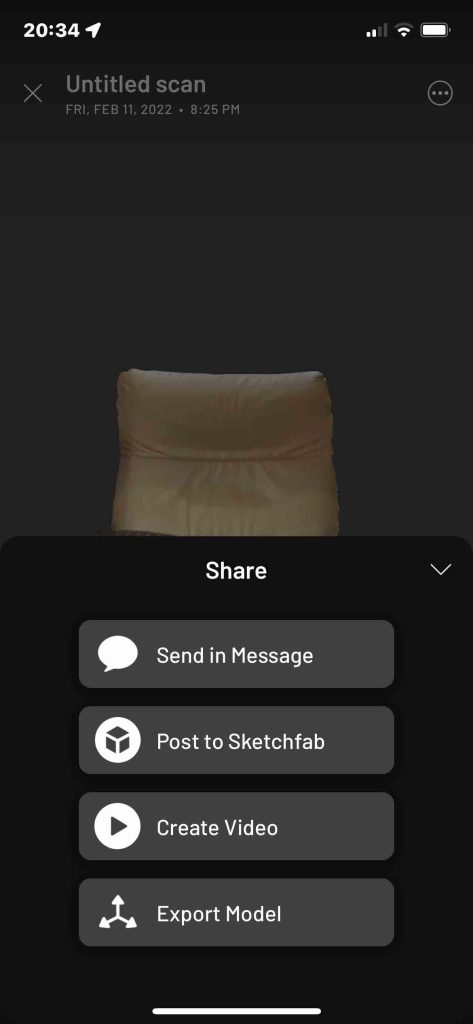

前もって撮影計画を立てる。何を撮りたいのか。行動力の鈍いぼくは,人生の大半を過ごしている隣室のTV観戦椅子を撮影することにする。もう外は暗い。この椅子の前後にLED球から構成される天井灯がありいずれも点灯したままで,椅子を少し移動して,この椅子を一周する形で撮影したい。画像は上記サイトのものを利用させて頂く。なお,Scanning modeの,EveryPoint Video + LiDAR Fusion,をタップすると,Coming Soon,が出て,選択できない。上から二番目の「EveryPoint LiDAR Fusion」はノイズが少なく撮影範囲は狭くなる。上から三番目と四番目はアップルの用意したARKitを使う場合であるが,「EveryPoint LiDAR Fusion」は,LiDARとEveryPointの写真測量アルゴリズムのデータを組み合わせた高密度の3D点群が作成される。

エブリポイントへのアプリ登録はすでに昨日,済んでいる。iPhone 12 Proのエブリポイントのアイコンをタップするとすぐに,EveryPointの画面が現れる。

1 比較的上部にある靑字の「EveryPoint LiDAR Fusion」をタップする。

2 そして,四択が出るが,上から二番目の「EveryPoint LiDAR Fusion」をタップし,下部にある靑地の「Start Scan」をタップする。

3 次に3D Voxel SizeとMax Scanning Depthの選択があるが,触らずに,靑字の「Start Scan」をタップする。

撮影対象の表面に赤〇が出て,黄色〇に,そして緑丸に変われば,どんどんと撮影域を移動してゆく。

撮影完了すると,Stopをタップする。

あとは室内でもできる作業。ただ,まだ,記録されていない。

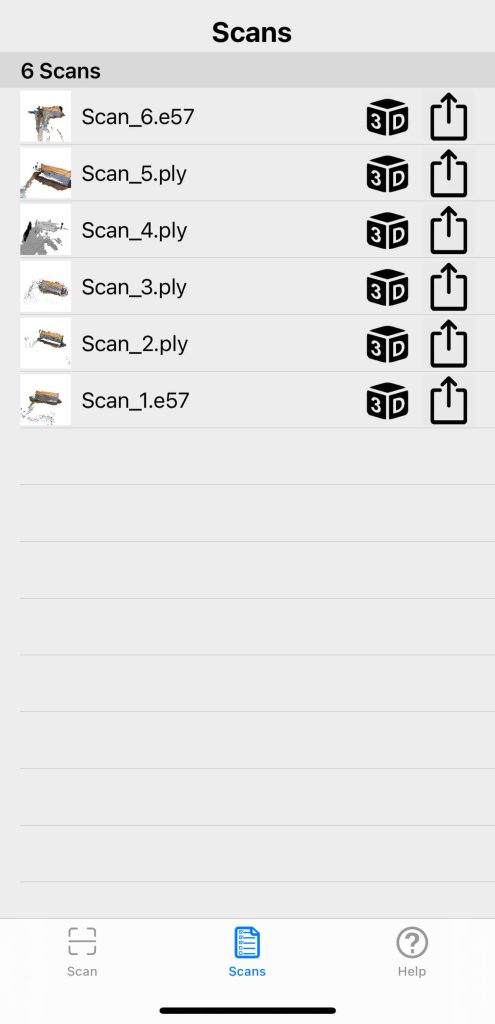

4 スキャンモデルの保存: ファイル形式の選択をするが,Sketchfabで公開するので,.plyを選択する。.ply のファイル形式(PoLYgon File FormatもしくはStanford Triangle Formatと呼ばれ,アスキー形式とバイナリー形式の両方がある)では,3Dスキャナからの3次元データ/色(透明性)、サーフィス法線、テクスチャ座標およびデータ信頼値,を得ることができる。

5 スキャンモデルの表示・共有:

画面下中央のScansから、過去に3Dスキャンしたモデル一覧を表示する。

それぞれスキャンファイルの3Dアイコンをタップして,モデルを参照したりポイントサイズを変更できる。

実際に撮影してわかったことであるが,サイズの変更はiPhoneでの見た目であって,ファイルには反映されない。

6 外部で共有: 3Dアイコン横の矢印アイコンをタップ。

7 Sketchfabにアップロード: Sketchfabを選択するとアプリから直接モデルをアップロードできる。その際,Sketchfabにアカウント登録する必要がある。ログイン後、EveryPointを通じてのアクセスを許可するとされ,ACCEPTをタップし,アップロードしたいスキャンモデルについて情報を入力する。

Sketchfabの入り口では,メールアドレスとパスワードが求められるが,この画面の最下部の方に,新らしいアカウント作成の選択リンクがあるので,ここから登録することになる。登録したメールアドレスに6桁の数字が送られるので,その数字をiPhone 12 Proで入力することで,登録が確定する。

アップロードしたら,メールで受け取り通知とそのurlがすぐに送られてくるので,Sketchfabのサイトで確かめることができる。不要な部分の3D voxelsを編集することはできない。

6 実際に撮影したら

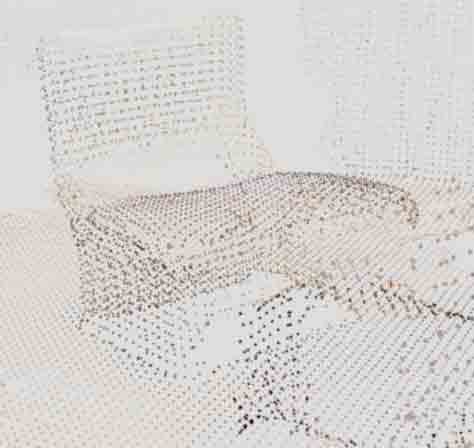

自宅居間のシングルソファを夜間に撮影した。

Scan 1 EveryPoint LiDAR Fusion voxel: 3cm depth: 5m

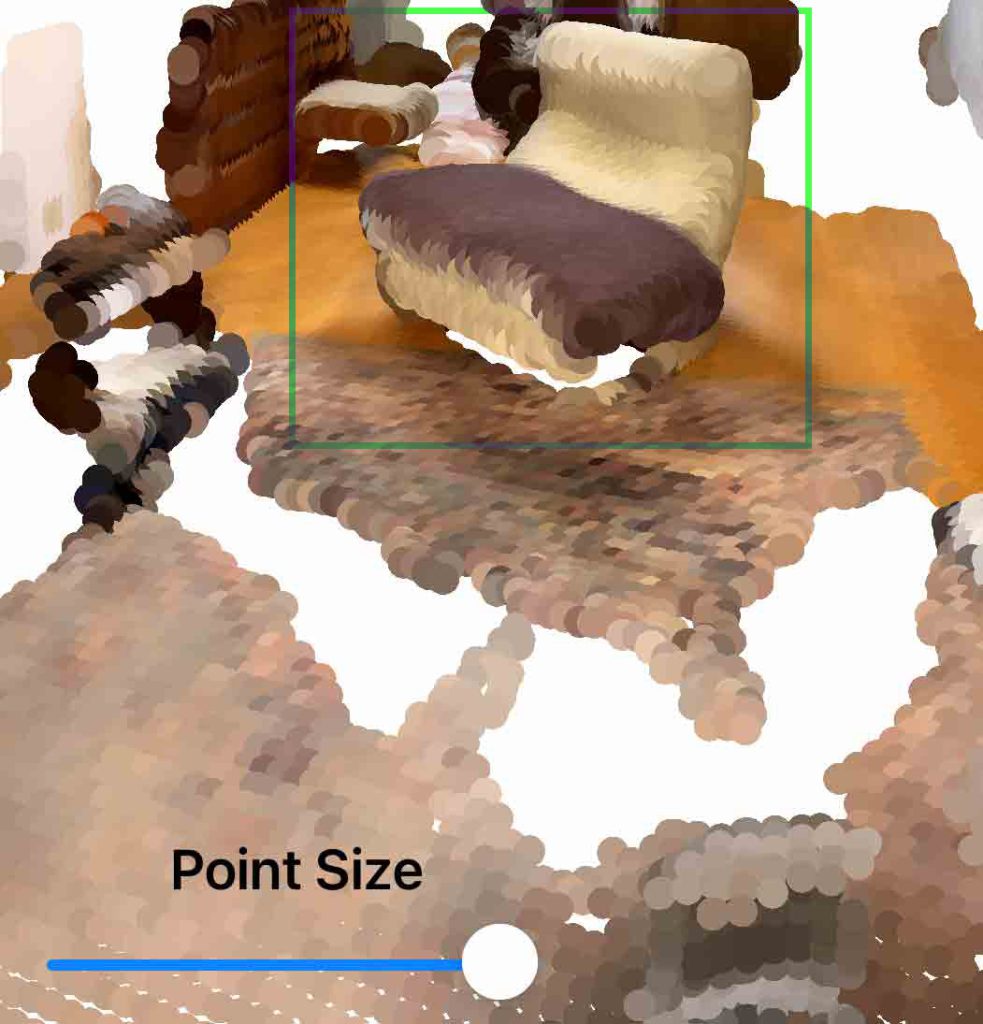

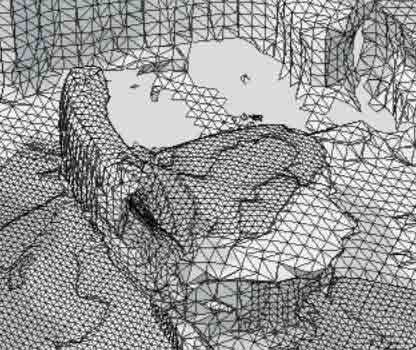

第5章エブリポイントを使う準備,で示した設定で撮影した。図4はSketchfabにアップロードしたもので,ポイント間が広くて,スカスカになっている。図5はiPhoneでポイントサイズを大きくして表示したもののスクリーンショットである。

————————————————

図5では,ポイントのサイズを変更したことで,緑色の枠で囲んだ椅子らしいのが見える。これはiPhone上での見かけのものである。椅子の周辺の不要なポイントの削除機能は無い。エブリポイントにも,Sketchfabにもない。

Scan 2 EveryPoint LiDAR Fusion voxel: 0.5 cm depth: 3 m

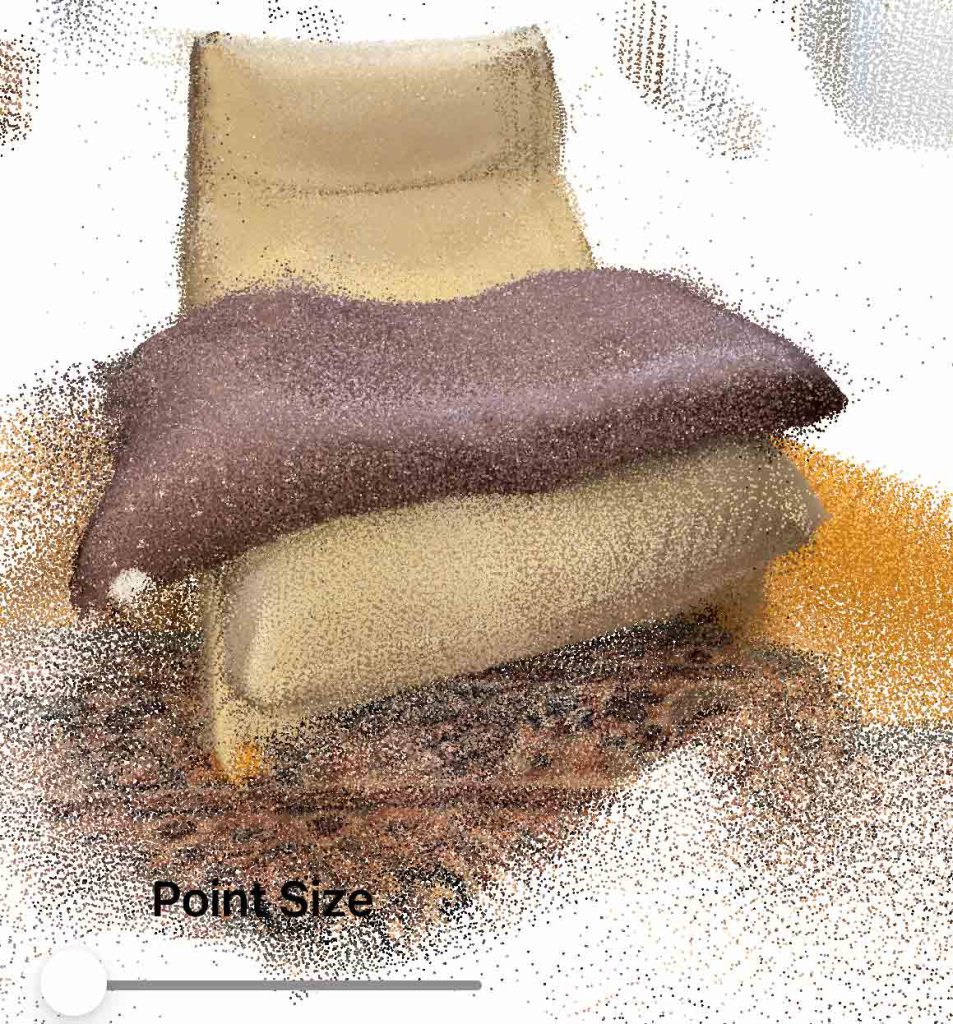

Scan 2: Scan 1を踏まえて,voxel sizeを,0.5, 1.0, 3.0 cmのうちの,最小値0.5 cmを採用して,ポイント密度を高めることができるのではと考えた。椅子のサイズから,max scanning depth を5mから3mに小さくした。図6と図7は同じファイルで視点が異なる。Scan 1と比べると,かなり改善されている。図8はiPhoneでポイントサイズを少し大きくしたものであるが,max scanning depthを小さくしたことで,画像そのものも大きくなっている。

Scan 1 撮影の際は,視界を椅子全部が見えるように配慮したが,部分を継ぎ合わせて行くという感覚で撮影した。その撮影法が椅子をより鮮明に捉え得たのではないだろうか。図6と図7では縞模様が見えるが,これはスキャンデータに隙間があるためであろう。その判断から,次には撮影法の残りの選択肢ARKit Lidar Pointsと,ARKit Lidar Meshでも撮影してみよう。

Scan 3: ARKit Lidar Points

このスキャニングモードは、LiDARセンサーの深度データとAppleのARKitを使用した高密度の3D点群を作成。はじめにScan Densityを設定,Smoothing Depth Mapを使用する場合は設定をオンにしましょう。confidence filterが三段階あり,low, medium, highの違いがわからない。

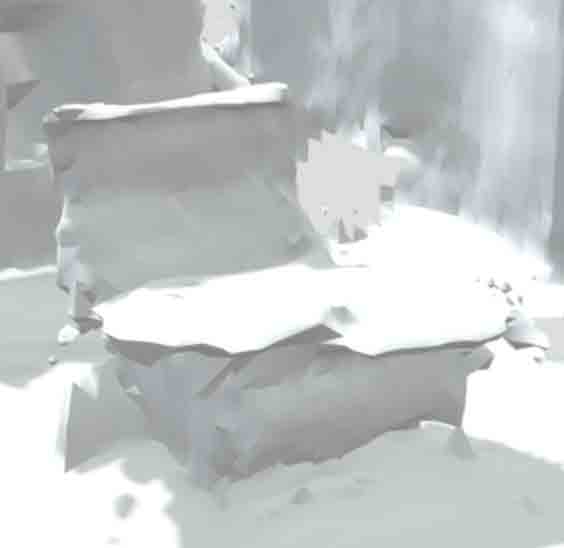

この方式はかなりメモリを食うようだ。ファイルが60MB余りで,Sketchfabの有料版が必要になったので,キャンセルし,scan densityを下げて,スキャンをやり直した。この方式では表面の質感が感ぜられる。ノイズは多いように感じる。これでも,Smoothing Depth Mapにチェックを入れたと思う。EveryPoint LiDAR Fusionのような点の間のスカスカ感はない。

以上,Feb. 11, 2022記。

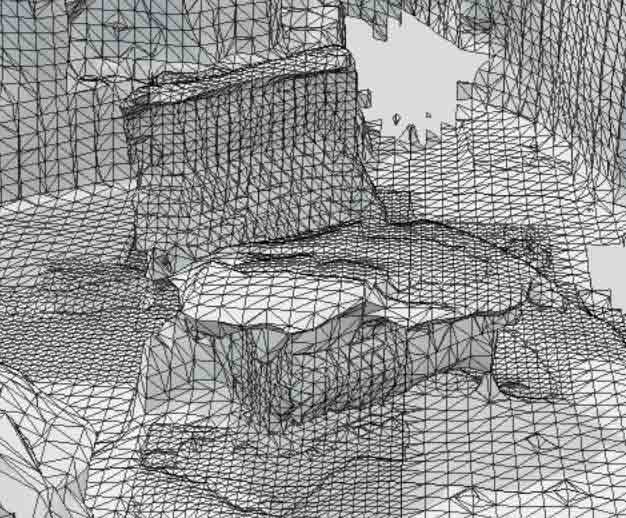

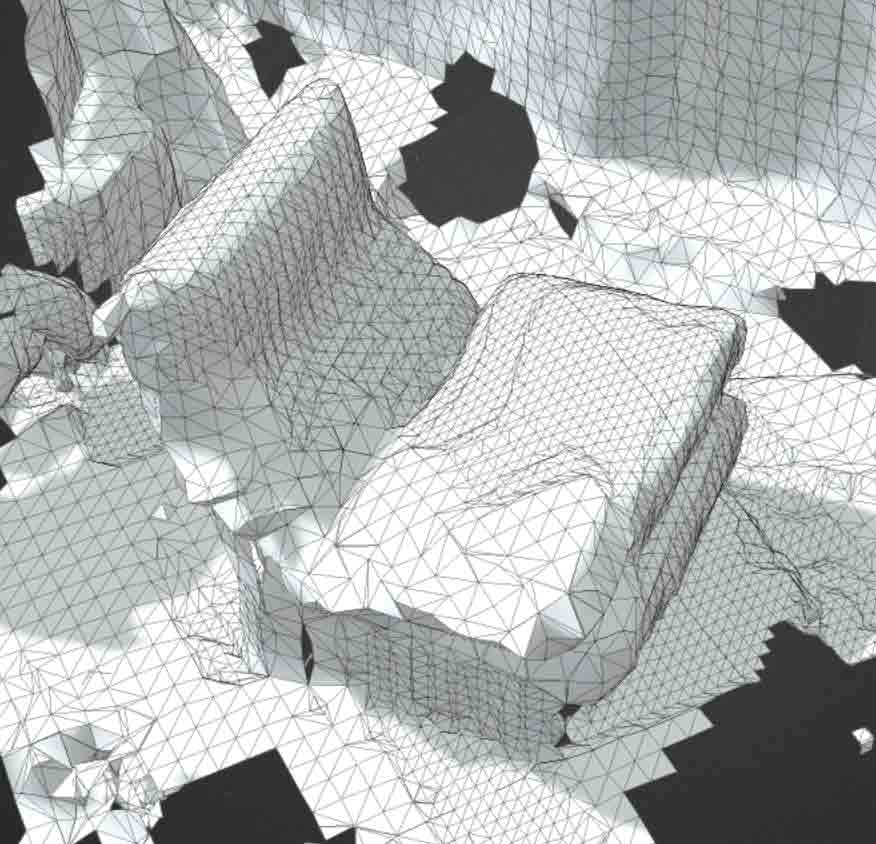

Scan 4: ARKit Lidar Mesh (撮影時の表現を選択 mesh or wireframe)

LiDAR対応の3Dジオメトリをベースにした三角形のメッシュが作成される。この3DジオメトリはAppleのARKitがシーンを内部的に再構築する際に生成するもの。Displayモードとして,meshとwireframeがあり,camera pass throughを最大にするのがデフォルトか。カメラの移動ルートを感じさせるということなのか? わからない。

「Displayモードとして,meshとwireframeがあり」,の意味は,生成される3D画像は同じだけど,スキャンしている際の本人がスキャンを観察しやすいかどうかという問題に過ぎない。室内では両方観察できるが,後者は繊細で,屋外ではmeshの方が観察しやすいと思う。

このARKit Lidar Meshモードでは,グレイ表示だな。

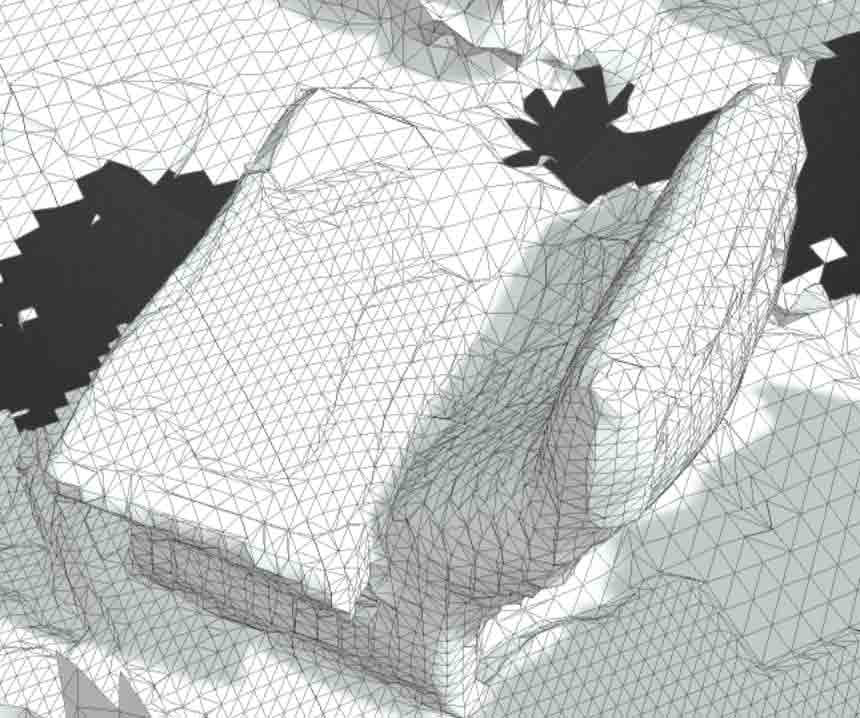

さて,図12〜図16は,すべて,ARKit Lidar Mesh,で得たものである。図12〜図14はmesh表示で撮影,図15と図16はwireframe表示で撮影した。図12はSketchfabにアップした際の表示で,図13〜図16は,Sketchfabでの,右上のボタン “Edit 3D Setting” を選んで,wireframeを付けた結果である。図15と図16の撮影の際は,iPhone 12 Proを上下ひっくり返してレンズを下方にして撮影した。撮影時にはメニューはひっくり返っているが,撮影対象はひっくり返らない。撮影後の画像チェックでもひっくり返っていない。

わずかな経験であるが,撮影技術が何となく向上したような気がする。撮影画面のメッシュやワイアフレームを見ながら,カメラをうねるように上下して行くようになった。

四種の撮影結果の何となくの感想:

これだけの試技で,あまりに独断的ではあるが,ぼくの使用目的からすると,アップルの先進技術ARKitは,使わない方がいいようである。ARKitは,AR, augmented reality,の作成キットであるから,仮想現実を生み出すための,測量的観点だけから見ているぼくには,ノイズをわざわざ生み出す技術と思われるのである。

それゆえ,ぼくは,今後は,エブリポイントアプリについては,「EveryPoint LiDAR Fusion」だけを使うことにする。

7 Scaniverseアプリを試す

エブリポイントについて,無料ながら,ぼくにとって不満なことを次に。

問題点1 技術情報が公開されておらず簡便な操作法のみがヘルプにあるだけだ。

問題点2 座標値そのものを利用したいユーザーに対してサービスする発想が今のところ無い。

問題点3 出力ファイル形式は,.e57 レーザースキャナーや光学式レンジカメラ、LiDARなどの画像で使用されるバイナリ形式+XML形式,と,.ply 3Dスキャナからの3次元データ/色(透明性)、サーフィス法線、テクスチャ座標およびデータ信頼値,に限定されている。

問題点4 撮影後の画像にはかなり撮影者にとって邪魔なvoxelがあるが,これを削除する機能が提供されていない。

ひょっとすると,”Video+LiDAR Fusion”が装備される時に有料化するという戦略かも知れないとはおもっている。この技術を使っての動画や”研究?”が拡散しているので。

Scaniverseもエブリポイントと大きな違いは無いが,ネット上で見てると簡便性がエブリポイントよりも高く,出力ファイル形式がより多様のように思われる。

(問題点3)3Dモデルとしては,FBX, OBJ, GLB, USDZ, STL,点群としては,ply, lasである。(問題点4)撮影した画像を鉛直にして,トリムもできる。撮影後すぐに保存ファイル形式を決定する必要はなく,エキスポートの際に選ぶことができる。

ネット検索して,スキャンデータをArchicadで活用!iPadPro iPhone12Pro LiDARセンサースキャン のページに巡り会った。このページは,Archicadという建築関係のCADソフトに関係する企業のものであるが,期待したように,Archicadを使わなくても,iPhone 12 Proで3Dスキャンした対象の座標値群つまり,point cloud(点群)を扱うことができそうである。上記サイトの記述から次のような手順が考えられる。

1 Scaniverseで,点群または3Dモデルを取得する。

2 Scaniverseから,点群のplyファイル形式と,3DモデルのFBX形式(FBX, FilmBoX, はデジタルコンテンツ作成 アプリ間の相互運用性を提供するために使用されてきた)で,出力する。

3 点群変換アプリCloudCompare(Windows版かmac版)をダウンロードする。

4 CloudCompareで点群plyファイルを取り込み,ascii出力する。この過程で点群の座標値とRGB値を得ることができる。CloudCompareの機能をまだぼくは知らない。

5 (CloudCompareの機能をまだぼくは知らないがひょっとすると次の段階は必要無いかも知れないが)メッシュ変換及びポリゴンリダクションアプリBlender(Windows版かmac版)をダウンロードする。

6 3DモデルFBXファイルをBlenderに取り込んでモデルを表示する(できるかどうかわからない)。

以上のような流れを想定して,まずは,Scaniverseでスキャンした。

使用法は上掲のScaniverseロゴの右手のリンクに示されているが座標系を求める方面については記されていない。スキャニバースScaniverseはスキャンして生まれる宇宙ってな意味なのか。

a iPhone 12 Pro上のスキャニバースアプリのロゴをタップすると,すぐに 赤地の “Create Scan”が最下部に現れるので,それをタップすると,ムービーを撮る際の赤ボタンが現れる。これをタップするとスキャンが始まる。終了するのは,ムービー同様,赤ボタンを再度押せばよい。

b エブリポイントよりは高速で,スキャン済みの領域は,通常のムービーを撮っている時のように画像が現れる。スキャンが終わっていない場所は斜めの赤白縞模様になっている。iPhone 12 Proを止めずにゆっくりとiPhone 12 Proを移動してゆくのがいいようだ。エブリポイントよりかなり高速だ。撮影した場所でまだ記録されていない場合,そこまで戻っても問題が無いようだ。

c 終了すると,自動で処理する際の3択が出てくるが,今回の場合,昼閒の無照明の室内であるが自動で認知していたので,そのままその指示に従った。今日,Feb. 12では,屋外での撮影で,高精度の方を敢えて選んだ。多少,保存に時間がかかったか。

d 図17に示した画面の一つ前の画面の際に,最下部のメニューで,Editを選ぶと,自動で画像が鉛直になって真上からの視野となり,トリミングの枠も現れる。図17のように,下部にCROP & ROTATEのスケールが現れ,それをスライドすると画像が求める位置を取ってくれる。トリミングの枠をこのソファに図17のように近づけて,右下の✓記号をタップすると,図18のように枠内が拡大表示される

e Editアイコンを選んで実行すると,文字”Save”が現れるので,それをタップする。

f 最下部のアイコンの右端の”SHARE”を選ぶと,図19が現れる。

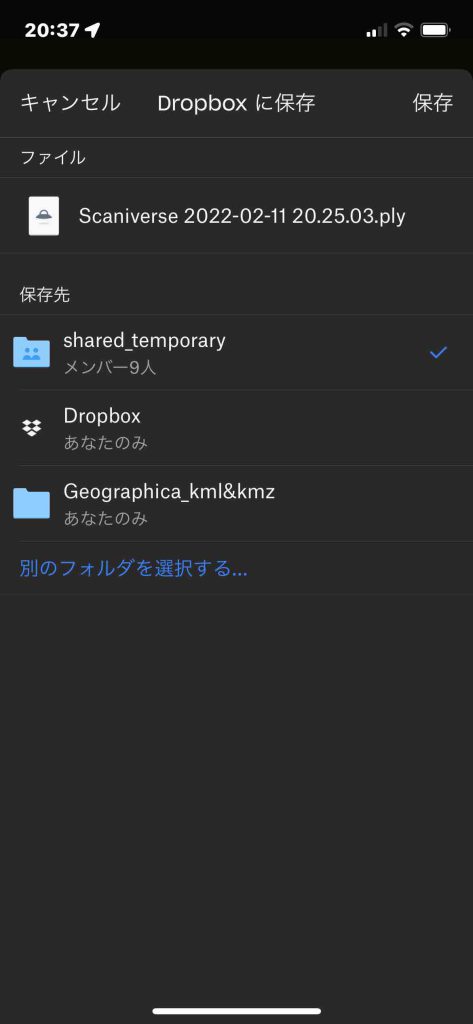

g ここでは,最下部のExport Modelを選ぶと,幾つかの選択肢がアイコンで現れ,Dropboxを選ぶ。その次だったかに,スキャンで得た情報の出力ファイル形式の選択があり,

h 図20では.plyとなっている。この図では,木庭のmacなどで共有するshared_temporaryフォルダを選んだことがわかる。

次のリンクは,safariでは実行できません。Google Chromeは問題ありませんでした。このリンクには, エブリポイントとスキャニバースから,Sketchfabに3Dスキャンファイルをアップロードしました。次のリンクのものは,スキャニバースで作成したものです。これを見て頂いて後,motochanロゴをクリックして頂くと,二つのエブリポイントの「Scan 4: ARKit Lidar Mesh」の3Dスキャンファイルが見て頂けます。スキャニバースがかなり優れていることがわかると思います。

”https://sketchfab.com/3d-models/my-chair-22882e4eb779417280b30cacffed6bdc”

今日Feb. 12, 2020,初めて屋外で撮影しました。亀岡市のタニハで草刈などして午後5時頃,日が射さなくなった,門柱を撮影しました。頂面は背伸びしましたが画面を見ることができず,空白が目立っています。

以上で,

1 Scaniverseで,点群または3Dモデルを取得する。

2 Scaniverseから,点群のplyファイル形式と,3DモデルのFBX形式で,出力する。

は,実行した。

以下,次のような展開がある。

3 点群変換アプリCloudCompare(Windows版かmac版)をダウンロードする。

4 CloudCompareで点群plyファイルを取り込み,ascii出力する。この過程で点群の座標値とRGB値を得ることができる。CloudCompareの機能をまだぼくは知らない。

次のページに展開したい。

iPhone 12 Pro撮影の3Dスキャン画像の座標を捉える

以上,Feb. 12, 2020記。